Introdução ao pré-processamento de dados no Machine Learning

O pré-processamento de dados no Machine Learning é uma maneira de converter dados do formulário bruto para um formato muito mais formatado, inutilizável ou desejado. É uma tarefa integral do aprendizado de máquina que é realizada pelo cientista de dados. Como os dados coletados estão em um formato bruto, pode não ser possível treinar o modelo usando-o. É importante processar esses dados brutos com cuidado para fazer uma interpretação adequada e, finalmente, evitar qualquer resultado negativo na previsão. Em resumo, a qualidade do nosso algoritmo de aprendizado depende muito do tipo de conjunto de dados que usamos para alimentar o modelo, de modo que o pré-processamento de dados é usado para manter essa qualidade.

Os dados coletados para o treinamento do modelo são de várias fontes. Esses dados coletados geralmente estão em seu formato bruto, ou seja, podem ter ruídos como valores ausentes e informações relevantes, números no formato de string etc. ou podem não ser estruturados. O pré-processamento de dados aumenta a eficiência e a precisão dos modelos de aprendizado de máquina. Como ajuda a remover esses ruídos e conjuntos de dados e dar sentido ao conjunto de dados

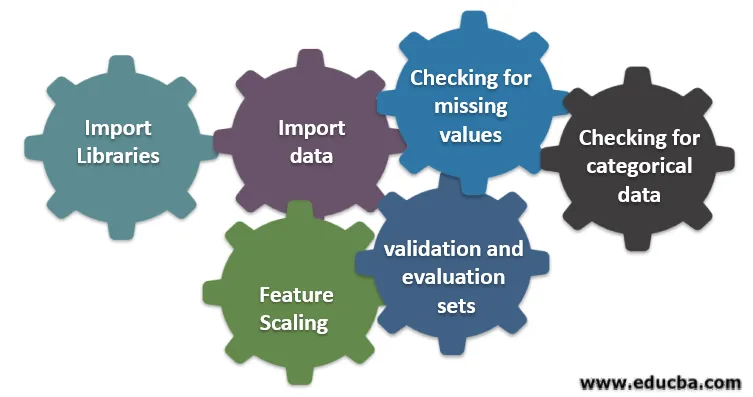

Seis etapas diferentes envolvidas no aprendizado de máquina

A seguir, seis etapas diferentes envolvidas no aprendizado de máquina para executar o pré-processamento de dados:

Etapa 1: Importar bibliotecas

Etapa 2: importar dados

Etapa 3: Verificando valores ausentes

Etapa 4: verificando dados categóricos

Etapa 5: Escala de recursos

Etapa 6: Dividindo dados em conjuntos de treinamento, validação e avaliação

Vamos entender cada uma dessas etapas em detalhes:

1. Importar bibliotecas

O primeiro passo é importar algumas das bibliotecas importantes necessárias no pré-processamento de dados. Uma biblioteca é uma coleção de módulos que podem ser chamados e usados. Em python, temos muitas bibliotecas que são úteis no pré-processamento de dados.

Algumas das seguintes bibliotecas importantes em python são:

- Numpy: Utilizava principalmente a biblioteca para implementar ou usar computação matemática complicada de aprendizado de máquina. É útil na execução de uma operação em matrizes multidimensionais.

- Pandas : é uma biblioteca de código aberto que fornece alto desempenho e fácil de usar a estrutura de dados e ferramentas de análise de dados em python. Ele foi projetado de maneira a tornar fácil e intuitivo o trabalho com dados de relacionamento e dados rotulados.

- Matplotlib: é uma biblioteca de visualização fornecida pelo python para plotagens 2D ou array. Ele é construído em uma matriz numpy e projetado para funcionar com uma pilha Scipy mais ampla. A visualização de conjuntos de dados é útil no cenário em que grandes dados estão disponíveis. Os gráficos disponíveis no matplot lib são: linha, barra, dispersão, histograma etc.

- Seaborn: também é uma biblioteca de visualização fornecida pelo python. Ele fornece uma interface de alto nível para desenhar gráficos estatísticos atraentes e informativos.

2. Importar conjunto de dados

Depois que as bibliotecas forem importadas, nosso próximo passo é carregar os dados coletados. A biblioteca do Pandas é usada para importar esses conjuntos de dados. Principalmente, os conjuntos de dados estão disponíveis em formatos CSV, pois são de tamanho baixo, o que facilita o processamento. Portanto, para carregar um arquivo csv usando a função read_csv da biblioteca do panda. Vários outros formatos do conjunto de dados que podem ser vistos são

Depois que o conjunto de dados é carregado, precisamos inspecioná-lo e procurar qualquer ruído. Para fazer isso, precisamos criar uma matriz de características X e um vetor de observação Y em relação a X.

3. Verificando valores ausentes

Depois de criar a matriz de recursos, você poderá encontrar alguns valores ausentes. Se não lidarmos com isso, poderá causar um problema no momento do treinamento.

Existem dois métodos para lidar com os valores ausentes:

- Removendo a linha inteira que contém o valor ausente, mas pode haver a possibilidade de você perder algumas informações vitais. Essa pode ser uma boa abordagem se o tamanho do conjunto de dados for grande.

- Se uma coluna numérica tiver um valor ausente, você poderá estimar o valor usando a média, a mediana, o modo etc.

4. Verificando dados categóricos

Os dados no conjunto de dados devem estar em uma forma numérica para executar o cálculo nele. Como os modelos de aprendizado de máquina contêm computação matemática complexa, não podemos fornecer a eles um valor não numérico. Portanto, é importante converter todos os valores de texto em valores numéricos. A classe LabelEncoder () de aprendido é usada para converter esses valores categóricos em valores numéricos.

5. Escala de Recursos

Os valores dos dados brutos variam extremamente e podem resultar em treinamento tendencioso do modelo ou podem acabar aumentando o custo computacional. Portanto, é importante normalizá-los. O dimensionamento de recursos é uma técnica usada para trazer o valor dos dados em um intervalo menor.

Os métodos usados para o dimensionamento de recursos são:

- Reescalonar (normalização min-max)

- Normalização média

- Padronização (Normalização do escore Z)

- Escalonamento para o comprimento da unidade

6. Divisão de dados em conjuntos de treinamento, validação e avaliação

Finalmente, precisamos dividir nossos dados em três conjuntos diferentes, conjunto de treinamento para treinar o modelo, conjunto de validação para validar a precisão do nosso modelo e, finalmente, conjunto de teste para testar o desempenho do nosso modelo em dados genéricos. Antes de dividir o conjunto de dados, é importante embaralhar o conjunto de dados para evitar vieses. Uma proporção ideal para dividir o conjunto de dados é 60:20:20, ou seja, 60% como conjunto de treinamento, 20% como conjunto de teste e validação. Para dividir o conjunto de dados, use train_test_split de sklearn.model_selection duas vezes. Uma vez para dividir o conjunto de dados em conjunto de trem e validação e depois dividir o conjunto de dados de trem restante em conjunto de trem e teste.

Conclusão - Pré-processamento de Dados no Machine Learning

O pré-processamento de dados é algo que requer prática. Não é como uma estrutura de dados simples na qual você aprende e aplica diretamente para resolver um problema. Para obter um bom conhecimento sobre como limpar um conjunto de dados ou como visualizá-lo, você precisa trabalhar com diferentes conjuntos de dados.

Quanto mais você usar essas técnicas, melhor entenderá. Essa era uma ideia geral de como o processamento de dados desempenha um papel importante no aprendizado de máquina. Junto com isso, também vimos as etapas necessárias para o pré-processamento de dados. Portanto, da próxima vez antes de treinar o modelo usando os dados coletados, aplique o pré-processamento dos dados.

Artigos recomendados

Este é um guia para pré-processamento de dados no Machine Learning. Aqui discutimos a introdução, Seis etapas diferentes envolvidas no aprendizado de máquina. Você também pode consultar nossos outros artigos sugeridos para saber mais:

- Importância da inteligência artificial

- Tecnologia IoT

- Tipos de dados PL / SQL

- Tipos de dados do Hive

- Tipos de dados R