Introdução aos métodos de kernel no Machine Learning

O algoritmo usado para a análise de padrões é denominado como Método do Kernel no Machine Learning. Em geral, a análise é feita para encontrar relações nos conjuntos de dados. Essas relações podem ser agrupamento, classificação, componentes principais, correlação, etc. Muitos desses algoritmos que resolvem essas tarefas de análise do padrão, precisam ser explicitamente transformados em uma representação de vetor de característica. Essa transformação pode ser feita através de um mapa de recursos especificado pelo usuário. Portanto, pode-se considerar que apenas o kernel especificado pelo usuário é requerido pelo método kernel.

A terminologia Kernal Method vem do fato de que eles usam a função do kernel, que lhes permite executar a operação no espaço de recurso implícito e de alta dimensão, sem a necessidade de calcular as coordenadas dos dados naquele espaço. Em vez disso, eles simplesmente calculam o produto interno entre as imagens de todos os pares de dados no espaço de recursos.

Esses tipos de operações são computacionalmente mais baratos na maioria das vezes, em comparação com o cálculo explícito das coordenadas. Essa técnica é denominada como 'truque do kernel'. Qualquer modelo linear pode ser convertido em um modelo não linear aplicando o truque do kernel ao modelo.

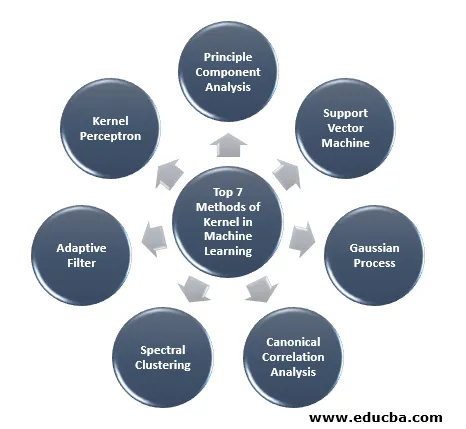

O método do kernel disponível no aprendizado de máquina é a análise de componentes principais (PCA), agrupamento espectral, máquinas de vetores de suporte (SVM), análise de correlação canônica, perceptron do kernel, processos gaussianos, regressão de crista, filtros adaptativos lineares e muitos outros. Vamos ter um entendimento de alto nível de alguns desses métodos do kernel.

Os 7 principais métodos de kernel no aprendizado de máquina

Aqui estão os métodos de Kernel no Machine Learning mencionados abaixo:

1. Análise de componentes principais

A análise de componentes principais (PCA) é uma técnica para extrair estrutura de conjuntos de dados possivelmente de alta dimensão. É prontamente realizado usando algoritmos iterativos que estimam componentes principais ou resolvendo um problema de autovalor. PCA é uma transformação ortogonal do sistema de coordenadas em que descrevemos nossos dados. O novo sistema de coordenadas é obtido por projeção nos principais eixos dos dados. Um pequeno número de componentes principais geralmente é suficiente para responder pela maior parte da estrutura nos dados. Uma de suas principais aplicações é realizar análise exploratória de dados para criar um modelo preditivo. É usado principalmente para visualizar a relação entre populações e distância genética.

2. Máquina de vetores de suporte

O SVM pode ser definido como um classificador para separar hiperplano em que hiperplano é o subespaço de uma dimensão menor que o espaço ambiente. A dimensão desse espaço matemático é definida como o número mínimo de coordenadas necessárias para especificar qualquer ponto, enquanto o espaço ambiente é o espaço que circunda o objeto matemático. Agora, objeto matemático pode ser entendido como um objeto abstrato que não existe em nenhum momento ou lugar, mas existe como um tipo de coisa.

3. Processo Gaussiano

O processo gaussiano recebeu o nome de Cark Friedrich Gauss porque usa a notação de distribuição gaussiana (distribuição normal). É um processo estocástico, o que significa uma coleção de variáveis aleatórias indexadas por tempo ou espaço. No Processo Gaussiano, variáveis aleatórias têm uma distribuição normal multivariada, ou seja, todas as combinações lineares finitas dela são normalmente distribuídas. O processo gaussiano usa as propriedades herdadas de uma distribuição normal e, portanto, são úteis na modelagem estatística. O algoritmo de aprendizado de máquina que envolve esse método do kernel usa a medida de aprendizado lento e a semelhança entre pontos para prever o valor de pontos não vistos dos dados de treinamento. Essa previsão não é apenas a estimativa, mas a incerteza nesse ponto.

4. Análise de correlação canônica

A Análise de correlação canônica é uma maneira de inferir informações de matrizes de covariância cruzada. É também conhecida como análise de variáveis canônicas. Suponha que temos dois vetores X, Y da variável aleatória, digamos dois vetores X = (X1, …, Xn) e vetor Y = (Y1, …, Ym), e a variável tendo correlação, então o CCA calculará uma combinação linear de X e Y, que tem a correlação máxima entre si.

5. Clustering espectral

Na aplicação da segmentação de imagens, o agrupamento espectral é conhecido como categorização de objetos com base em segmentação. No Clustering espectral, a redução de dimensionalidade é realizada antes do clustering em menor dimensão, isso é feito usando o valor próprio da matriz de similaridade dos dados. Ele tem suas raízes na teoria dos grafos, onde essa abordagem é usada para identificar comunidades de nós em um gráfico que se baseia nas arestas que os conectam. Esse método é flexível o suficiente e nos permite agrupar dados também de não gráficos.

6. Filtro Adaptativo

O filtro adaptativo utiliza um filtro linear que compreende uma função de transferência, que é controlada por parâmetros variáveis e pelos métodos, que serão utilizados para ajustar esses parâmetros de acordo com o algoritmo de otimização. A complexidade desse algoritmo de otimização é a razão pela qual todo filtro adaptativo é um filtro digital. Um filtro adaptativo é necessário naquelas aplicações em que não há informações anteriores sobre a operação de processamento desejada com antecedência ou elas estão sendo alteradas.

A função de custo é usada no filtro adaptativo de circuito fechado, pois é necessária para o desempenho ideal do filtro. Ele determina como modificar a função de transferência de filtro para reduzir o custo da próxima iteração. Uma das funções mais comuns é o erro quadrático médio do sinal de erro.

7. Perceptron do Kernel

No aprendizado de máquina, o perceptron do kernel é um tipo do algoritmo de aprendizado perceptron popular que pode aprender máquinas do kernel, como classificadores não lineares que usam uma função do kernel para calcular a similaridade daquelas amostras que não são vistas em amostras de treinamento. Este algoritmo foi inventado em 1964, tornando-o o primeiro aluno de classificação do kernel.

A maioria dos algoritmos de kernel discutidos é baseada em otimização convexa ou em problemas próprios e estatisticamente bem fundamentada. Suas propriedades estatísticas são analisadas usando a teoria da aprendizagem estatística.

Falando sobre as áreas de aplicação dos métodos do kernel, é diverso e inclui geoestatística, krigagem, ponderação de distância inversa, reconstrução 3D, bioinformática, quimioinformática, extração de informações e reconhecimento de escrita.

Conclusão

Resumi algumas das terminologias e tipos de métodos do kernel no Machine Learning. Devido à falta de espaço, este artigo não é de forma alguma abrangente e visa apenas a você entender o que é o método do kernel e um breve resumo de seus tipos. No entanto, a cobertura deste artigo fará com que você dê o primeiro passo no campo do Machine Learning.

Artigos recomendados

Este é um guia para o Método Kernel no Machine Learning. Aqui discutimos os 7 tipos de métodos de kernel no Machine Learning. Você também pode consultar o seguinte artigo.

- Núcleo Monolítico

- Clustering no Machine Learning

- Aprendizado de máquina de ciência de dados

- Aprendizado de máquina não supervisionado

- Filtros PHP | Como validar a entrada do usuário usando vários filtros?

- Guia completo do ciclo de vida do aprendizado de máquina