Introdução à lista de comandos do Hadoop FS

O Hadoop funciona em seu próprio sistema de arquivos, que é distribuído por natureza, conhecido como "HDFS do sistema de arquivos distribuído do Hadoop " . O Hadoop depende de armazenamento distribuído e processamento paralelo. Essa maneira de armazenar o arquivo em locais distribuídos em um cluster é conhecida como Sistema de Arquivos Distribuídos Hadoop, isto é, HDFS. Para executar várias operações no nível do arquivo, o HDFS fornece seu próprio conjunto de comandos Conhecido como Comandos do Sistema de Arquivos Hadoop. Vamos explorar esses comandos. Neste tópico, vamos aprender sobre o Hadoop FS Command.

Comandos do Hadoop FS

Qualquer comando HDFS possui o prefixo "hdfs dfs". Isso significa que estamos especificando que o sistema de arquivos padrão é o HDFS. Vamos explorar os comandos um por um

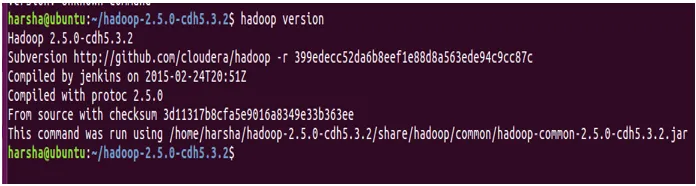

1. Versões

O comando version é usado para encontrar a versão do Hadoop instalada no sistema.

Sintaxe: Hadoop version

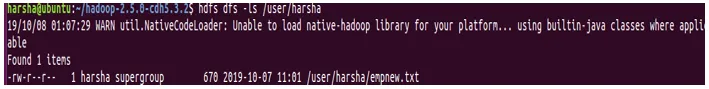

2. Comando ls

O comando ls no Hadoop é usado para especificar a lista de diretórios no caminho mencionado. O comando ls usa o caminho hdfs como parâmetro e retorna uma lista de diretórios presentes no caminho.

Sintaxe: hdfs dfs -ls

Exemplo: hdfs dfs -ls / user / harsha

Também podemos usar -lsr no modo recursivo

Sintaxe: hdfs dfs –lsr

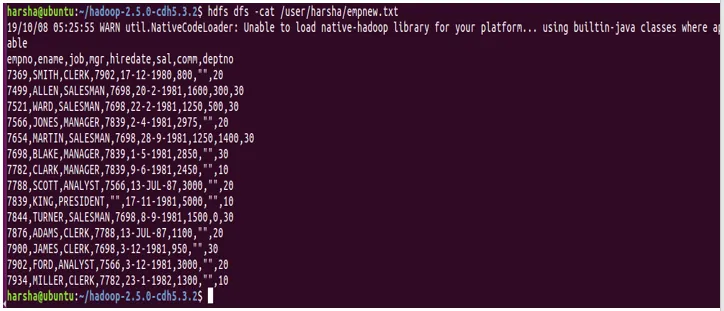

3. Comando Gato

O comando Cat é usado para exibir o conteúdo do arquivo no console. Este comando usa o caminho do arquivo hdfs como argumento e exibe o conteúdo do arquivo.

Sintaxe: hdfs dfs -cat

Exemplo: hdfs dfs -cat /user/harsha/empnew.txt

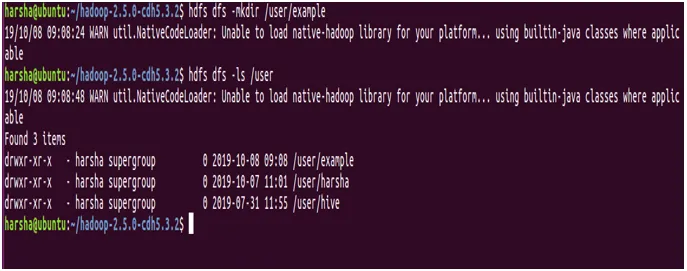

4. comando mkdir

O comando mkdir é usado para criar um novo diretório no sistema de arquivos hdfs. Ele pega o caminho hdfs como argumento e cria um novo diretório no caminho especificado.

Sintaxe: hdfs dfs -mkdir

Exemplo: hdfs dfs -mkdir / user / example

Na captura de tela acima, é claramente mostrado que estamos criando um novo diretório chamado "exemplo" usando o comando mkdir e o mesmo é mostrado usando o comando ls.

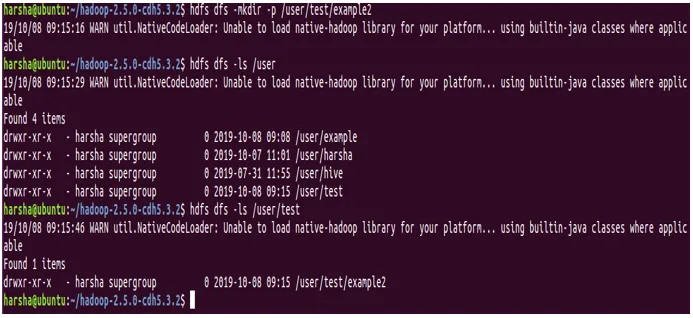

Também para o comando mkdir, podemos dar a opção '-p'. Ele cria diretórios-pai no caminho, se estiverem ausentes.

Exemplo: hdfs dfs -mkdir -p / user / test / example2

Na captura de tela acima, é bastante evidente que temos a opção -p e no caminho / usuário / teste / exemplo2, os diretórios testes e exemplo2 são criados.

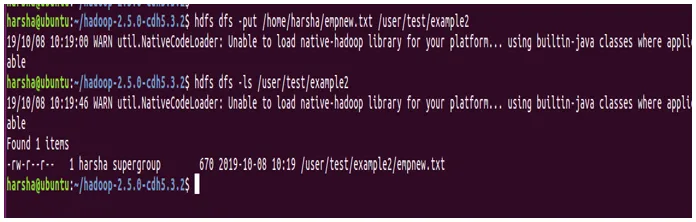

5. comando put

colocar o comando no HDFS é usado para copiar arquivos do local de origem especificado para o caminho hdfs de destino. Aqui o local de origem pode ser um caminho do sistema de arquivos local. O comando put recebe dois argumentos, o primeiro é o caminho do diretório de origem e o segundo é o caminho do HDFS de destino

Sintaxe: hdfs dfs -put

Exemplo: hdfs dfs -put /home/harsha/empnew.txt / user / test / example2

Na captura de tela acima, podemos ver claramente que o arquivo é copiado da origem para o destino.

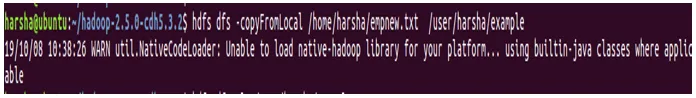

6. comando copyFromLocal

O comando copyFromLocal no HDFS é usado para copiar arquivos do caminho de origem para o caminho de destino. A origem neste comando é restrita ao sistema de arquivos local

Sintaxe: hdfs dfs -copyFromLocal /home/harsha/empnew.txt/user/harsha/example

Diferença entre o comando put e o comando copyFromLocal: Não há muita diferença entre esses dois comandos de shell hdfs. Ambos são usados para copiar do sistema de arquivos local para direcionar o caminho do arquivo HDFS.

Mas o comando put é mais útil e robusto, pois permite copiar vários arquivos ou diretórios para o destino no HDFS

hdfs dfs -put

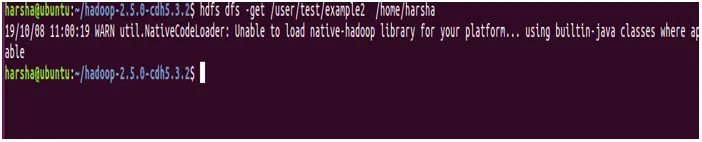

7. comando get

O comando get em hdfs é usado para copiar um arquivo ou diretório hdfs específico para o caminho do sistema de arquivos local de destino. São necessários dois argumentos, um é o caminho dos hdfs de origem e o outro é o caminho do sistema de arquivos local de destino

Sintaxe: hdfs dfs -get

Exemplo: hdfs dfs -get / user / test / example2 / home / harsha

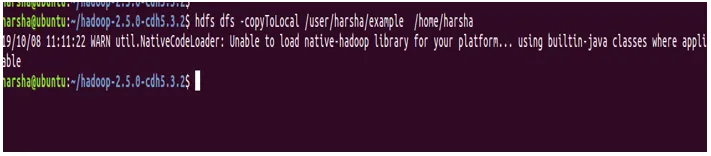

8. comando copyToLocal

O comando copyToLocal em hdfs é usado para copiar um arquivo ou diretório em hdfs para o sistema de arquivos local. Neste comando, o destino é fixo no sistema de arquivos local. Este comando copyFromLocal é semelhante ao comando get.

Sintaxe: hdfs dfs -copyToLocal

Exemplo: hdfs dfs -copyToLocal / user / harsha / example / home / harsha

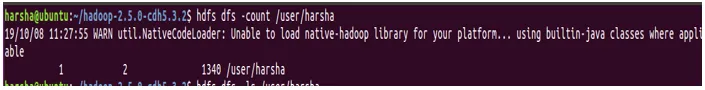

9. comando count

O comando count em hdfs é usado para contar o número de diretórios presentes no caminho especificado. O comando count usa um determinado caminho como argumento e fornece o número de diretórios presentes nesse caminho.

Sintaxe: hdfs dfs -count

Exemplo: hdfs dfs -count / user

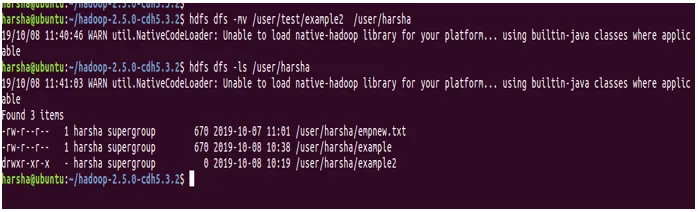

10. comando mv

O comando mv em hdfs é usado para mover um arquivo entre hdfs. O comando mv pega o arquivo ou diretório do caminho hdfs de origem especificado e o move para o caminho hdfs de destino.

Sintaxe : hdfs dfs -mv

Exemplo : hdfs dfs -mv / user / test / example2 / user / harsha

Na captura de tela acima, podemos ver que o diretório example2 agora está presente em / user / harsha

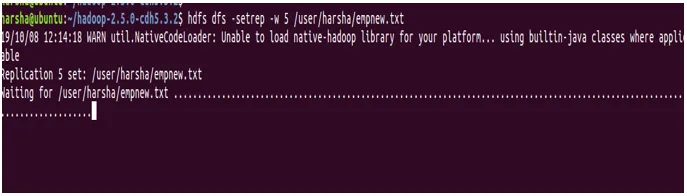

11. comando setrep

O comando setrep em hdfs é usado para alterar o fator de replicação do arquivo fornecido. Por padrão, o hdfs possui um fator de replicação '3'. Se o caminho especificado for um diretório, este comando alterará o fator de replicação de todos os arquivos presentes nesse diretório.

Sintaxe: hdfs dfs -setrep (-R) (-w)

-w: Este sinalizador especifica que o comando deve aguardar a conclusão da replicação.

rep: fator de replicação

Exemplo: hdfs dfs -setrep -w 5 /user/harsha/empnew.txt

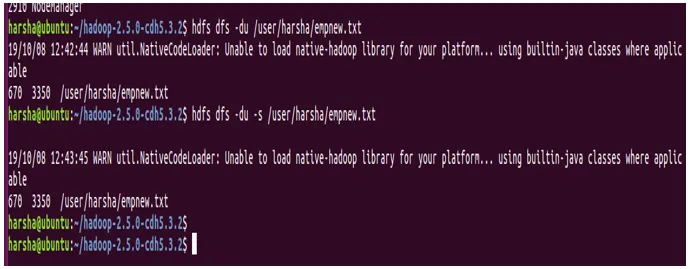

12. comando du

O comando du em hdfs mostra a utilização do disco para o caminho hdfs fornecido. Ele pega o caminho hdfs como entrada e retorna a utilização do disco em bytes.

Sintaxe : hdfs dfs -du

Exemplo: hdfs dfs -du /user/harsha/empnew.txt

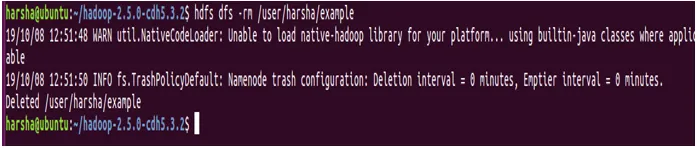

13. comando rm

O comando rm em hdfs é usado para remover arquivos ou diretórios no caminho hdfs fornecido. Este comando usa o caminho hdfs como entrada e remove os arquivos presentes nesse caminho.

Sintaxe : hdfs dfs -rm

Exemplo : hdfs dfs -rm / user / harsha / example

Conclusão - Comando Hadoop FS

Por meio deste, conhecemos vários comandos hdfs, suas respectivas sintaxes com exemplos também. Devemos notar que kick start qualquer comando hdfs, precisamos executar o script bin / hdfs. O hdfs é seguido por uma opção conhecida como dfs, que indica que estamos trabalhando com o sistema de arquivos distribuídos Hadoop. Com a ajuda dos comandos mencionados acima, podemos negociar com o sistema de arquivos HDFS.

Artigos recomendados

Este é um guia para o Hadoop FS Command. Aqui discutimos os comandos HDFS usados com mais freqüência. Você também pode consultar o seguinte artigo para saber mais -

- Arquitetura Hadoop

- Estrutura HADOOP

- Instale o Hadoop

- Ferramentas Hadoop

- Versões do Tableau

- Guia para a lista de comandos do Unix Shell