Diferença entre Hadoop e SQL

Os enormes dados gerados a cada segundo via Mídia Social, como Facebook, Twitter e Instagram, abriram o caminho para o desenvolvimento do Hadoop / Big Data Ecosystem. O termo "3V" referente a Volume, Velocidade e Veracidade define a importância do Hadoop para manipular os dados de streaming. Hoje, os dados são gerados a partir de várias fontes, as quais precisam ser integradas para diversos fins, como relatórios, análise de dados e pesquisa, e para armazenamento centralizado de dados. Quando fazemos isso, surgem vários problemas com as abordagens tradicionais, como espaço, acesso, integridade, estrutura e largura de banda. Para lidar com todos esses problemas, o Hadoop fornece uma estrutura que permite processar os dados com tamanho enorme, fornecer acesso fácil, alta disponibilidade e carregar dados dinamicamente. Possui uma estrutura de sistema de arquivos distribuídos (HDFS) para o armazenamento de dados e o processador de consultas incorporado chamado “Map Reduce” para análise e processamento de dados armazenados no HDFS.

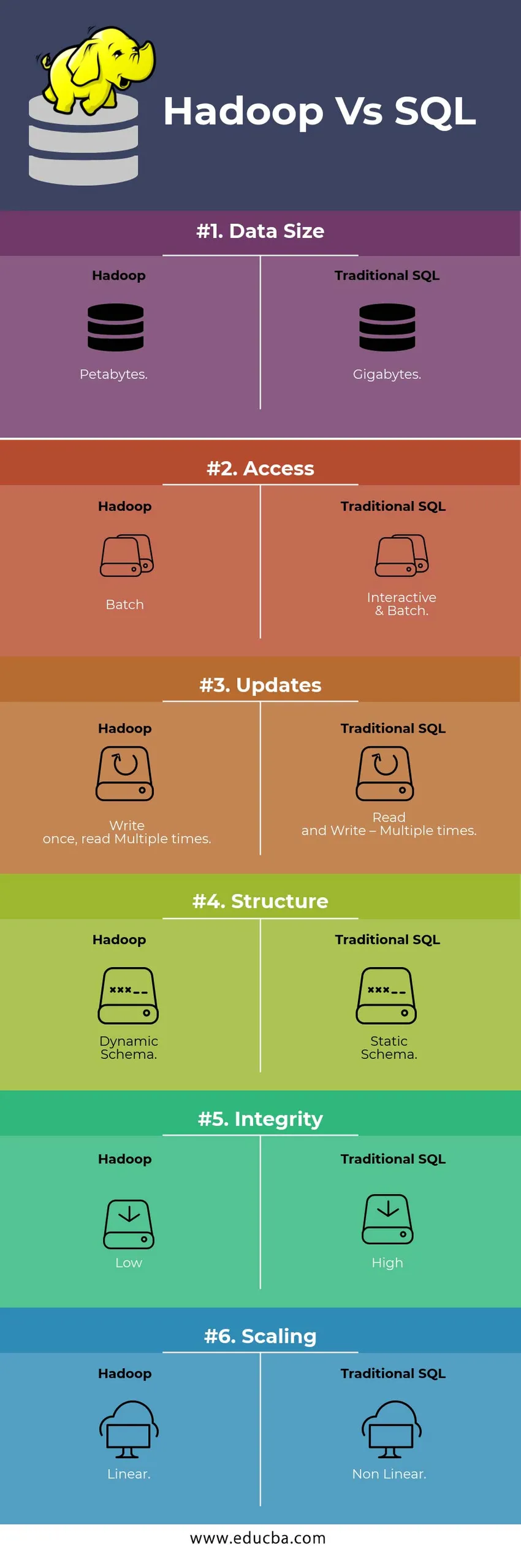

Comparação direta entre o Hadoop e o SQL

Abaixo está a diferença entre os 6 principais entre o Hadoop Vs SQL

Principais diferenças entre o Hadoop Vs SQL

Abaixo está a diferença entre Hadoop e SQL:

- Esquema em WRITE Vs READ

Geralmente em um banco de dados tradicional, durante o carregamento / migração de dados de um banco de dados para outro, segue o esquema na abordagem de gravação. Isso faz com que o processo de carregamento de dados fique excitado / abortado e resulta na rejeição de registros devido a uma diferença na estrutura das tabelas de origem e destino, enquanto no sistema Hadoop - todos os dados são armazenados no HDFS e os dados são centralizados.

A estrutura do Hadoop é usada principalmente para o processo de análise de dados. Assim, ele suporta todas as três categorias de dados, isto é, dados estruturados, semiestruturados e não estruturados e permite a abordagem do esquema na leitura.

- Os dados estruturados têm um formato definido. g .: arquivo XML.

- Os dados de Semiestruturas são mais frouxos; Pode / não tem um esquema. g .: Planilha

- Os dados não estruturados não possuem uma estrutura ou esquema específico. Por exemplo: Texto sem formatação ou Imagem.

O Hadoop trabalha eficientemente com dados não estruturados, pois possui a capacidade de interpretar os dados durante o tempo de processamento.

| Abordagem | Vantagem | Dis Advantage |

| Esquema na gravação | Estruturas pré-definidas

· Leitura mais rápida. Por exemplo: RDBMS tradicional. | Carregamento lento de dados

Alta latência |

| Esquema na leitura | · Estrutura dinâmica

· Escrever e ler rapidamente. Por exemplo: Hadoop | Carregamento rápido de dados

Baixa latência |

Tabela : Esquema no esquema WRITE VS no READ.

- ESCALABILIDADE E CUSTO

O Hadoop Framework foi projetado para processar um grande volume de dados. Sempre que o tamanho dos dados aumenta, vários recursos adicionais, como o nó de dados, podem ser adicionados ao cluster com muita facilidade do que a abordagem tradicional da alocação de memória estática. Tempo e orçamento são relativamente muito menores para implementá-los e também o Hadoop fornece localidade de dados onde os dados são disponibilizados no nó que executou a tarefa.

- TOLERÂNCIA AO ERRO

No RDBMS tradicional, quando os dados são perdidos devido a corrupção ou qualquer problema de rede, leva mais tempo, custo e recursos para recuperar os dados perdidos. Porém, o Hadoop possui um mecanismo no qual os dados têm no mínimo três níveis de fator de replicação para os dados armazenados no HDFS. Se um dos nós de dados que contém dados falhar, os dados poderão ser facilmente extraídos de outros nós com alta disponibilidade de dados. Portanto, torna os dados prontamente disponíveis para o usuário, independentemente de qualquer falha.

- PROGRAMAÇÃO FUNCIONAL

O Hadoop suporta escrever programação funcional em linguagens como java, scala e python. Para qualquer aplicativo que exija funcionalidade adicional, pode ser implementado registrando UDF - Funções definidas pelo usuário no HDFS. No RDBMS, não há possibilidade de gravar UDF e isso aumenta a complexidade da gravação de SQL. Além disso, os dados armazenados no HDFS podem ser acessados por todo o ecossistema do Hadoop como Hive, Pig, Sqoop e HBase. Portanto, se o UDF for gravado, ele poderá ser usado por qualquer aplicativo mencionado acima. Aumenta o desempenho e a capacidade de suporte do sistema.

- OTIMIZAÇÃO

O Hadoop armazena dados no HDFS e no Process embora Map Reduce com enormes técnicas de otimização. As técnicas mais populares usadas para manipular dados estão usando o particionamento e o agrupamento dos dados armazenados. O particionamento é uma abordagem para armazenar os dados no HDFS, dividindo os dados com base na coluna mencionada para particionamento. Quando os dados são injetados ou carregados no HDFS, eles identificam a coluna da partição e os empurram para o diretório de partições em questão. Portanto, a consulta busca o conjunto de resultados buscando diretamente os dados do diretório particionado. Isso reduz toda a verificação da tabela, melhora o tempo de resposta e evita a latência.

Outra abordagem é chamada de Bucketing dos dados. Isso permite que o analista distribua facilmente os dados entre os nós de dados. Todos os nós terão um número igual de dados distribuídos. A coluna de balde é selecionada de maneira a ter o menor número de cardinalidade.

Essas abordagens não estão disponíveis no método tradicional do SQL.

- TIPO DE DADOS

Em uma abordagem tradicional, o tipo de dados suportado é muito limitado. Ele suporta apenas dados estruturados. Assim, para limpar e formatar o próprio esquema de dados, levará mais tempo. Porém, o Hadoop suporta tipos de dados complexos como Matriz, Estrutura e Mapa. Isso incentiva o uso dos diferentes tipos de um conjunto de dados a serem usados para o carregamento de dados. Para Ex: os dados XML podem ser carregados definindo-os com elementos XML que contêm tipos de dados complexos.

- COMPRESSÃO DE DADOS

Existem muito menos técnicas de compactação embutidas disponíveis para o sistema de banco de dados tradicional. Mas para a estrutura do Hadoop, existem muitas técnicas de compactação, como gzib, bzip2, LZO e snappy. O modo de compactação padrão é LZ4. Até as tabelas podem ser compactadas usando as técnicas de compressão como Parquet, ORC. As técnicas de compactação ajudam a fazer com que as tabelas ocupem muito menos espaço, aumentam a taxa de transferência e a execução mais rápida da consulta.

Tabela de comparação do Hadoop Vs SQL

| Características | SQL tradicional | Hadoop |

| Tamanho dos dados | Gigabytes | Petabytes |

| Acesso | Interativo e em lote | Lote |

| Atualizações | Leitura e gravação - Várias vezes | Escreva uma vez, leia Várias vezes |

| Estrutura | Esquema estático | Esquema Dinâmico |

| Integridade | Alto | Baixo |

| Dimensionamento | Não linear | Linear |

Tabela : Comparação entre o Hadoop Tradicional e o SQL Framework.

Conclusão - Hadoop Vs SQL

No geral, o Hadoop está à frente do SQL tradicional em termos de custo, tempo, desempenho, confiabilidade, suporte e disponibilidade de dados para um grande grupo de usuários. Para lidar com eficiência com a enorme quantidade de dados gerados todos os dias, a estrutura do Hadoop ajuda na captura, armazenamento, processamento, filtragem e filtragem oportunos em um local centralizado.

Artigo recomendado

- Hadoop vs Hive - Descubra as melhores diferenças

- Aprenda a 10 diferença útil entre Hadoop e Redshift

- HADOOP vs RDBMS | Conheça as 12 diferenças úteis

- Apache Hadoop vs Apache Spark | As 10 melhores comparações que você deve saber!

- Hadoop vs Spark: Recursos