O que é o ecossistema Apache Hadoop?

O Apache Hadoop Ecosystem é uma estrutura ou uma plataforma de dados de código aberto designada para salvar e examinar as enormes coleções de dados não estruturados. Em todo o mundo, há uma tonelada de dados sendo lançados de inúmeras plataformas digitais com a principal tecnologia inovadora de big data. Além disso, o Apache Hadoop foi o primeiro a obter esse fluxo de inovação.

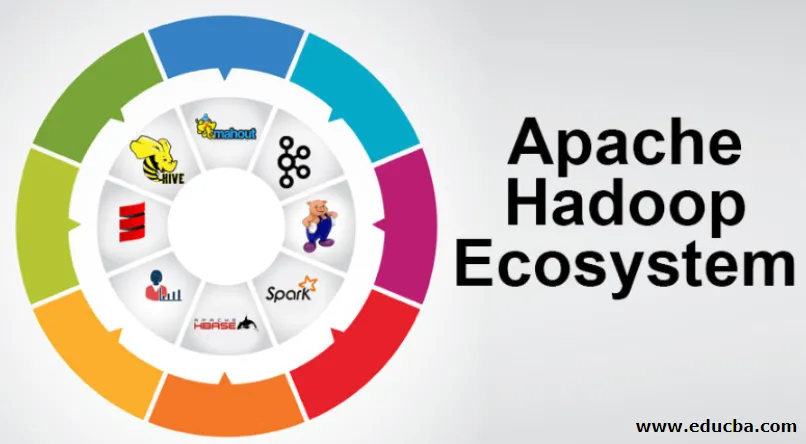

O que compreende a arquitetura / ecossistema do Hadoop Data?

O ecossistema Hadoop não é uma linguagem de programação ou um serviço, é uma estrutura ou plataforma que cuida de problemas de big data. Você pode identificá-lo como um conjunto que envolve vários serviços, como armazenamento, ingestão, manutenção e análise dentro dele. Em seguida, examine e obtenha um pensamento conciso sobre como os serviços funcionam exclusivamente e em cooperação. A arquitetura do Apache Hadoop é composta por diferentes inovações e elementos do Hadoop, através dos quais até os problemas complicados de informações podem ser resolvidos com eficiência.

A seguir está a representação de cada parte: -

1) Namenode: Orienta o processo de informação

2) Datanode: Compõe as informações para armazenamento local. Salvar todas as informações em um local singular não é continuamente sugerido, pois pode causar perda de informações em caso de interrupção.

3) Rastreador de tarefas: Eles recebem tarefas alocadas ao nó escravo

4) Mapa: pega informações de um fluxo e cada linha é tratada dividida para separá-las em campos diferentes

5) Diminuir: Aqui os campos adquiridos através do Mapa são reunidos ou vinculados entre si

Ecossistema Apache Hadoop - passo a passo

Todos os elementos do ecossistema Hadoop, como aspectos específicos, são óbvios. A perspectiva abrangente sobre a estrutura do Hadoop oferece qualidade notável ao Hadoop Distributed File Systems (HDFS), Hadoop YARN, Hadoop MapReduce e Hadoop MapReduce do ecossistema do Hadoop. O Hadoop ainda oferece todas as bibliotecas Java, registros significativos de Java, reflexão no nível do SO, vantagens e scripts para operar o Hadoop, o Hadoop YARN é um método para delinear os negócios e gerenciar recursos. Na configuração do Hadoop, o HDFS fornece alta taxa de transferência de informações de aplicativos e o Hadoop MapReduce fornece preparação paralela baseada em YARN de extensas sortidas de dados.

Visão geral do ecossistema Apache Hadoop

É um assunto fundamental a ser compreendido antes de você começar a trabalhar com o Ecossistema Hadoop. Abaixo estão os componentes essenciais:

- HDFS: Essa é a parte central do ecossistema Hadoop e pode economizar uma enorme quantidade de informações não estruturadas, estruturadas e semiestruturadas.

- FIO: Assemelha-se à mente do ecossistema Hadoop e todo o manuseio é realizado diretamente aqui, o que pode incorporar alocação de ativos, agendamento de tarefas e preparação de ações.

- MapReduce: É uma mistura de dois processos, descritos como Mapear e Reduzir, e compreende essencialmente a preparação de peças que compõem grandes coleções de informações, utilizando algoritmos paralelos e dispersos no ecossistema Hadoop.

- Apache Pig: é uma linguagem do procedimento, que é utilizada para aplicativos de manipulação paralela para processar vastas coleções de informações na condição Hadoop e essa linguagem é uma opção para a programação Java.

- HBase: É um banco de dados de código aberto e não associado ou NoSQL. Ele reforça todos os tipos de informações, portanto, pode lidar com qualquer tipo de informação dentro de uma estrutura do Hadoop.

- Mahout, Spark MLib: O Mahout é utilizado para aprendizado de máquina e dá natureza à criação de aplicativos de aprendizado de máquina.

- Zookeeper: Para lidar com os grupos, pode-se utilizar o Zookeeper, também chamado de senhor da coordenação, que pode oferecer administrações operacionais confiáveis, rápidas e organizadas para os grupos Hadoop.

- Oozie: O Apache Oozie opera a programação de trabalho e atua como um serviço de alerta e relógio dentro do ecossistema Hadoop.

- Ambari: É um empreendimento da Apache Software Foundation e pode executar o ecossistema do Hadoop progressivamente flexível.

FIO Hadoop:

Pense no YARN como a mente do seu ecossistema Hadoop. Ele executa a totalidade de suas operações de processamento, alocando ativos e tarefas de planejamento.

Possui dois segmentos dignos de nota: ResourceManager e NodeManager.

- ResourceManager: - É novamente um nó importante na divisão operacional. Ele recebe as consultas de preparação e, depois disso, passa as consultas para relacionar os NodeManagers, respectivamente, onde ocorre o manuseio genuíno.

- NodeManagers: - Eles são instalados em cada DataNode. É responsável pela execução de uma atribuição em cada DataNode.

Como o apache Hadoop funciona?

- Ele pretende subir de servidores individuais para uma enorme quantidade de máquinas, cada uma fornecendo capacidade e computação local. Em vez de depender do equipamento para transmitir alta acessibilidade, a própria biblioteca tem como objetivo distinguir e lidar com desapontamentos na camada de aplicativos, fornecendo um serviço extremamente acessível a vários PCs, cada um dos quais pode estar inclinado a desapontamentos.

- Olhe além, no entanto, e há um charme significativamente crescente no trabalho. O Hadoop é totalmente modular, o que implica que você pode trocar praticamente qualquer um de seus segmentos por uma ferramenta de software alternativa. Isso torna a arquitetura fantasticamente adaptável, igualmente poderosa e eficaz.

Apache Hadoop Spark:

- O Apache Spark é um sistema para análise de informações em tempo real em uma configuração de computação dispersa. Ele implementa cálculos na memória para aumentar a velocidade do processamento de informações.

- É mais rápido para lidar com informações de grande escala, pois utiliza cálculos na memória e diferentes melhorias. Nessa linha, requer alta força de processamento.

Como o Apache Pig funciona?

- O Apache Pig é um sistema benéfico que o Yahoo foi desenvolvido para examinar vastas e efetivas posições de informações. Ele fornece uma linguagem de fluxo de informações de nível superior Pig Latin, aprimorada, extensível e simples de utilizar.

- O componente excepcional dos programas Pig nos quais sua composição está disponível para um paralelismo substancial, simplificando o processo de cuidar de coleções de informações substanciais.

Caso de uso do porco:

- As informações privadas de saúde de um indivíduo são particulares e não devem ser divulgadas a outras pessoas. Esses dados devem ser ocultados para manter o sigilo, mas as informações dos serviços medicinais são enormes, a ponto de reconhecer e excluir as informações individuais de saúde são essenciais. O Apache Pig pode ser utilizado em tais condições para desconhecer os dados de saúde.

Conclusão:

- Ele está descrito para subir de apenas um servidor para uma enorme quantidade de máquinas, todas fornecendo capacidade e computação nas proximidades. Olhe mais longe, no entanto, e há muito mais encantamento no trabalho.

- O Hadoop é totalmente modular, o que implica que você pode trocar praticamente qualquer uma de suas partes por uma ferramenta de software alternativa. Isso torna a estrutura fantasticamente adaptável, igualmente poderosa e eficaz.

Artigos recomendados

Este foi um guia para o Apache Hadoop Ecosystem. Aqui discutimos o que é o Apache Hadoop Ecosystem? visão geral da arquitetura do Hadoop e o funcionamento do ecossistema do Hadoop. Você também pode consultar nossos outros artigos sugeridos para saber mais -

- Componentes do ecossistema Hadoop

- Como instalar o Apache

- Treinamento Apache Spark

- Carreira no Hadoop