O que é a tecnologia de Big Data?

Como sabemos, os dados estão evoluindo constantemente. O crescimento dos dados desafiou as mentes humanas a extrair, analisar e lidar com isso. Isso ocorre porque as formas tradicionais de lidar com dados estão falhando no suporte a esse big data. O big data é descrito por três conceitos: volume, variedade e velocidade.

Os dados agora se tornaram o ativo mais importante de toda empresa. A análise desse big data ajuda a empresa a analisar o comportamento de seus clientes e a prever coisas relevantes associadas às decisões baseadas em dados que tomam a organização, a tomar atitudes mais confiantes e a construir estratégias mais fortes.

Sabendo o ritmo com o qual os dados estão aumentando na era atual, o big data será um campo gigantesco no futuro próximo para se trabalhar. Todos os alunos, calouros, profissionais serão necessários para se manterem atualizados com as tecnologias emergentes de big data. Manter-se atualizado trará uma grande e bem-sucedida carreira no caminho profissional.

Tecnologias de Big Data

Aqui, listarei algumas tecnologias de big data com uma explicação lúcida, para informá-lo sobre as próximas tendências e tecnologias:

-

Apache Spark:

É um mecanismo rápido de processamento de big data. Isso é construído tendo em mente o processamento em tempo real dos dados. Sua rica biblioteca de aprendizado de máquina é boa para trabalhar no espaço de IA e ML. Ele processa dados em paralelo e em computadores em cluster. O tipo de dados básico usado pelo Spark é RDD (conjunto de dados distribuído resiliente).

-

Bancos de dados NoSQL:

São bancos de dados não relacionais que fornecem armazenamento e recuperação rápidos de dados. Sua capacidade de lidar com todos os tipos de dados, como dados estruturados, semiestruturados, não estruturados e polimórficos, é única. Nenhum banco de dados SQL é dos seguintes tipos:

- Bancos de dados de documentos : armazena dados na forma de documentos que podem conter muitos pares diferentes de valores-chave.

- Armazena gráficos : armazena dados que geralmente são armazenados na forma de rede, como dados de mídia social.

- Armazenamentos de valores-chave : esses são os bancos de dados NoSQL mais simples. Cada item no banco de dados é armazenado como um nome de atributo (ou 'chave'), juntamente com seu valor.

- Armazéns de coluna ampla : esse banco de dados armazena dados no formato colunar, em vez de no formato baseado em linha. Cassandra e HBase são bons exemplos disso.

-

Apache Kafka:

Kafka é uma plataforma de streaming de eventos distribuídos que lida com muitos eventos todos os dias. Como é rápido e escalável, isso é útil na criação de pipelines de dados de streaming em tempo real que buscam dados de forma confiável entre sistemas ou aplicativos.

-

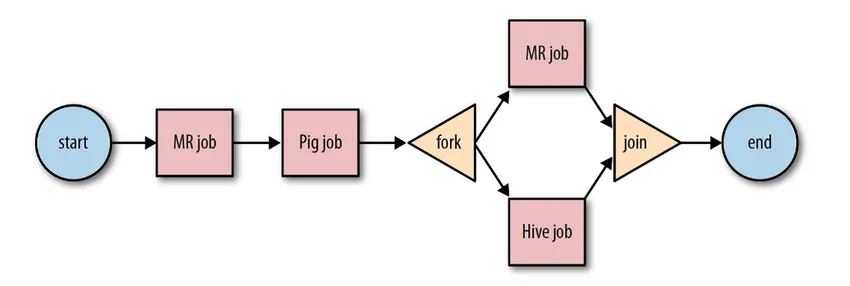

Apache Oozie:

É um sistema de agendador de fluxo de trabalho para gerenciar tarefas do Hadoop. Esses trabalhos de fluxo de trabalho são agendados em forma de gráficos acíclicos direcionados (DAGs) para ações.

Fonte: Google

Sua solução escalável e organizada para atividades de big data.

-

Apache Airflow:

Esta é uma plataforma que agenda e monitora o fluxo de trabalho. O agendamento inteligente ajuda a organizar a execução final do projeto com eficiência. O fluxo de ar possui a capacidade de executar novamente uma instância do DAG quando houver uma instância de falha. Sua rica interface de usuário facilita a visualização de pipelines em execução em vários estágios, como produção, monitoramento de progresso e solução de problemas quando necessário.

-

Apache Beam:

É um modelo unificado, para definir e executar pipelines de processamento de dados que incluem ETL e fluxo contínuo. A estrutura do Apache Beam fornece uma abstração entre a lógica do aplicativo e o ecossistema de big data, pois não existe uma API que ligue todas as estruturas, como Hadoop, spark, etc.

-

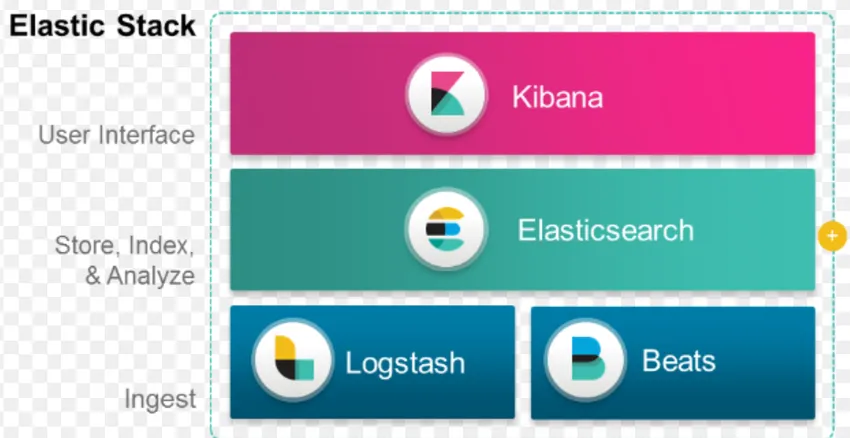

Pilha ELK:

O ELK é conhecido por Elasticsearch, Logstash e Kibana.

O Elasticsearch é um banco de dados sem esquema (que indexa todos os campos) que possui recursos de pesquisa poderosos e facilmente escaláveis.

O Logstash é uma ferramenta ETL que nos permite buscar, transformar e armazenar eventos no Elasticsearch.

Kibana é uma ferramenta de painel para Elasticsearch, onde você pode analisar todos os dados armazenados. Os insights acionáveis extraídos do Kibana ajudam na construção de estratégias para uma organização. Desde a captura de alterações até a previsão, o Kibana sempre se mostrou muito útil.

-

Docker & Kubernete:

Essas são as tecnologias emergentes que ajudam os aplicativos a serem executados em contêineres Linux. O Docker é uma coleção de ferramentas de código-fonte aberto que ajuda você a “Criar, enviar e executar qualquer aplicativo, em qualquer lugar”.

O Kubernetes também é uma plataforma de contêiner / orquestração de código aberto, permitindo que um grande número de contêineres trabalhe juntos em harmonia. Em última análise, isso reduz a carga operacional.

-

TensorFlow:

É uma biblioteca de aprendizado de máquina de código aberto usada para projetar, construir e treinar modelos de aprendizado profundo. Todos os cálculos são feitos no TensorFlow com gráficos de fluxo de dados. Os gráficos incluem nós e arestas. Os nós representam operações matemáticas, enquanto as bordas representam os dados.

O TensorFlow é útil para pesquisa e produção. Foi desenvolvido tendo em mente que ele poderia ser executado em várias CPUs ou GPUs e até em sistemas operacionais móveis. Isso pode ser implementado em Python, C ++, R e Java.

-

Presto:

O Presto é um mecanismo SQL de código aberto desenvolvido pelo Facebook, capaz de lidar com petabytes de dados. Ao contrário do Hive, o Presto não depende da técnica MapReduce e, portanto, é mais rápido na recuperação dos dados. Sua arquitetura e interface são fáceis o suficiente para interagir com outros sistemas de arquivos.

Devido à baixa latência e à fácil consulta interativa, hoje em dia está ficando muito popular o manuseio de big data.

-

Polybase:

O Polybase trabalha sobre o SQL Server para acessar dados armazenados no PDW (Parallel Data Warehouse). PDW criado para processar qualquer volume de dados relacionais e fornece integração com o Hadoop.

-

Colmeia:

O Hive é uma plataforma usada para consulta e análise de dados em grandes conjuntos de dados. Ele fornece uma linguagem de consulta semelhante ao SQL chamada HiveQL, que internamente é convertida em MapReduce e processada.

Com o rápido crescimento dos dados e o enorme esforço da organização para analisar os big data, a tecnologia trouxe tantas tecnologias maduras ao mercado que conhecê-las é de enorme benefício. Atualmente, a Big Data Technology está atendendo a muitas necessidades e problemas de negócios, aumentando a eficiência operacional e prevendo o comportamento relevante. Uma carreira em big data e sua tecnologia relacionada podem abrir muitas portas de oportunidades para a pessoa e para as empresas.

A partir de agora, é hora de adotar tecnologias de big data.

Artigos recomendados

Este foi um guia para o que é a tecnologia de big data. Aqui discutimos algumas tecnologias de big data como Hive, Apache Kafka, Apache Beam, ELK Stack etc. Você também pode consultar o seguinte artigo para saber mais -

- O que é o Deep Learning?

- Guia para o Minitab?

- O que é a tecnologia Salesforce?

- O que é análise de Big Data?