O que é porco?

O Pig é um mecanismo de código aberto, que faz parte das tecnologias do ecossistema Hadoop. O Pig é ótimo em trabalhar com dados que estão além dos bancos de dados tradicionais ou data warehouses. Isso pode lidar bem com dados ausentes, incompletos ou inconsistentes, que não possuem esquema. O Pig tem sua própria linguagem para expressar manipulações de dados, que é o Pig Latin.

Porco compreensivo

Pig é uma tecnologia que permite escrever scripts de alto nível, mas extremamente granulares, que permitem trabalhar com dados nos quais o esquema é desconhecido ou inconsistente. O Pig é uma tecnologia de código aberto que roda sobre o Hadoop e faz parte do ecossistema Hadoop extremamente vibrante e popular.

O Pig funciona bem com dados não estruturados e incompletos, para que você não precise ter o layout tradicional de regras e colunas para tudo.

É bem definido e pode funcionar diretamente em arquivos no HDFS (Hadoop Distributed File System).

O Pig será sua tecnologia de escolha quando você desejar obter dados da fonte em um data warehouse.

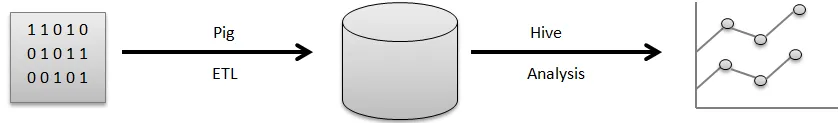

Por exemplo, um pipeline visual de como os dados normalmente fluem antes que você possa usá-los para gerar os bons gráficos que você usa para tomar decisões de negócios.

Os dados brutos vêm de uma variedade de fontes, como sensores, telefones celulares etc. Você usará o Pig para executar uma operação ETL. ETL significa extrair, transformar e carregar. Depois que essas operações são executadas, os dados limpos são armazenados em outro banco de dados. Um exemplo desse banco de dados seria o HDFS, que faz parte do Hadoop. O Hive é um armazém de dados que será executado em cima de um sistema de arquivos como este. Hive é o que você usaria para análise, para gerar os relatórios e extrair insights.

O ETL é uma etapa muito importante no processamento de dados para que os dados brutos sejam limpos e na forma correta para serem armazenados em um banco de dados. Extração refere-se à operação de extração de dados não estruturados e inconsistentes com campos e valores ausentes da fonte original. Transform significa a série de operações que você aplicaria nos dados para limpá-los ou obtê-los.

Pré-computação de informações agregadas úteis, processamento de campos para corresponder a um determinado formato, tudo isso faz parte da limpeza de dados dos campos de transformação.

Finalmente, o Pig realiza a operação de carregamento em que esses dados limpos são armazenados em um banco de dados, onde podem ser analisados posteriormente. Um exemplo de operação padrão que o Pig executa é limpar os arquivos de log.

Explique a arquitetura do porco

Existem inúmeras partes de Pig na arquitetura, preferem:

- Analisador : O analisador lida com os scripts do Pig, bem como, verifica a sintaxe do script, verifica a digitação e várias verificações variadas. Além disso, o resultado pode ser um DAG (Directed Acyclic Graph), que geralmente significa as reivindicações do Pig Latin junto com operadores lógicos.

Além disso, os operadores lógicos com o script serão mostrados como os nós, bem como os fluxos de dados, desde as bordas através do DAG.

- Otimizador: Posteriormente, o plano lógico (DAG) geralmente é excedido em relação ao otimizador lógico. Ele realiza as otimizações lógicas adicionais, incluindo projeção e promove baixa

- Compilador: o compilador também compila esse plano lógico aprimorado em um grupo de MapReduce.

- Mecanismo de Execução: Por fim, todos os trabalhos do MapReduce serão publicados no Hadoop dentro de uma sequência classificada. Eventualmente, isso gera os resultados necessários, embora esses trabalhos do MapReduce sejam executados com o Hadoop.

- MapReduce: O MapReduce foi originalmente projetado no Google como uma maneira de processar páginas da Web, de forma a impulsionar a pesquisa no Google. O MapReduce distribui a computação em várias máquinas no cluster. O MapReduce aproveita o paralelismo inerente ao processamento de dados. Sistemas modernos, como sensores ou até atualizações de status do Facebook, geram milhões de registros de dados brutos.

Uma atividade com esse nível pode ser preparada em duas fases:

- Mapa

- Reduzir

Você decide qual lógica deseja implementar nessas fases para processar seus dados.

- HDFS (Hadoop Distributed File System): O Hadoop está permitindo uma explosão de armazenamento e análise de dados em escala ilimitada. Os desenvolvedores estão usando um aplicativo como Pig, Hive, HBase e Spark para recuperar dados do HDFS.

Recursos

O Apache Pig vem com os seguintes recursos diferentes:

- A simplicidade da programação: o Pig Latin é comparável ao SQL e, portanto, é bastante simples para os desenvolvedores criarem um script do Pig. Caso você tenha um entendimento da linguagem SQL, é incrivelmente simples aprender a linguagem Latina do Pig, pois é exatamente como a linguagem SQL.

- Conjunto rico de operadores: O Pig inclui uma variedade de conjuntos ricos de operadores para poder executar procedimentos como junção, arquivador, classificação e muito mais.

- Possibilidades de otimização: O desempenho da tarefa no Apache Pig pode ser instantaneamente aprimorado pela própria tarefa; portanto, os desenvolvedores precisam apenas se concentrar na semântica dessa linguagem.

- Extensibilidade: Utilizando operadores acessíveis, os usuários podem simplesmente desenvolver suas funções para ler, processar e gravar dados.

- UDFs (User Define Functions): Usando o serviço fornecido pelo Pig para criar UDFs, poderíamos produzir Funções Definidas pelo Usuário no número de linguagens de desenvolvimento, incluindo Java, além de invocar ou incorporar todas elas nos Pig Scripts.

Para que serve o porco?

É utilizado para examinar e executar responsabilidades, incluindo manipulação ad-hoc. O Apache Pig pode ser usado para:

A análise com enormes coleções de dados brutos prefere o processamento de dados para obter sites de pesquisa. Como o Yahoo, o Google beneficia o Apache Pig para avaliar os dados coletados pelo Google, bem como pelos mecanismos de busca do Yahoo. Manipulação de grandes coleções de dados, como registros da web, informações on-line por streaming e assim por diante. Até as atualizações de status do Facebook geram milhões de registros de dados brutos.

Como essa tecnologia ajuda você a crescer em sua carreira?

Muitas organizações estão implementando o Apache Pig incrivelmente rápido. Isso significa que as profissões nas carreiras de porco e porco estão aumentando diariamente. Houve um enorme progresso no desenvolvimento do Apache Hadoop nos últimos dois anos. Elementos do Hadoop, como Hive, Pig, HDFS, HBase, MapReduce e assim por diante.

Embora as ofertas do Hadoop tenham entrado em sua segunda década neste momento, ainda tenham explodido em reconhecimento nos últimos três a quatro anos. Um grande número de empresas de software está aplicando clusters Hadoop incrivelmente comum. Essa pode ser definitivamente a melhor parte do big data. Os especialistas em mira podem se tornar experientes nesta excelente tecnologia.

Conclusão

O Apache Pig Expertise é muito requisitado no mercado e pode continuar a ser estendido. Simplesmente entendendo os conceitos e adquirindo experiência com as melhores habilidades do Apache Pig no Hadoop, os especialistas podem se envolver perfeitamente na profissão do Apache Pig.

Artigo recomendado

Este foi um guia para o que é o porco? Aqui discutimos os conceitos, definição e arquitetura com os recursos do Pig. Você também pode consultar nossos outros artigos sugeridos para saber mais -

- Como instalar o Apache

- Perguntas da entrevista do Apache PIG

- O que é o ASP.Net Web Services?

- O que é a tecnologia Blockchain?