Visão geral do Install Hadoop

O artigo a seguir, Instalar o Hadoop, fornece uma descrição dos principais módulos-chave da estrutura do Hadoop e a instalação passo a passo do Hadoop. O Apache Hadoop é uma coleção de software que permite o processamento de grandes conjuntos de dados e armazenamento distribuído em um cluster de diferentes tipos de sistema de computador. Atualmente, o Hadoop continua sendo a plataforma de análise mais usada para big data ("Sanchita Lobo, autor do Analytics Training Blog", nd).

Estrutura do Hadoop

A estrutura do Apache Hadoop consiste nos seguintes módulos principais.

- Apache Hadoop Common.

- Sistema de arquivos distribuídos (Apache Hadoop) (HDFS).

- Apache Hadoop MapReduce

- Apache Hadoop YARN (outro gerente de recursos).

Apache Hadoop Common

O módulo Apache Hadoop Common consiste em bibliotecas compartilhadas consumidas em todos os outros módulos, incluindo gerenciamento de chaves, pacotes de E / S genéricos, bibliotecas para coleta de métricas e utilitários para registro, segurança e streaming.

HDFS

O HDFS é baseado no sistema de arquivos do Google e está estruturado para rodar em hardware de baixo custo. O HDFS é tolerante a falhas e foi projetado para aplicativos com grandes conjuntos de dados.

MapReduce

O MapReduce é um modelo de programação paralela inerente ao processamento de dados e o Hadoop pode executar programas MapReduce escritos em várias linguagens, como Java. O MapReduce funciona dividindo o processamento na fase do mapa e reduz a fase.

Apache Hadoop YARN

O Apache Hadoop YARN é um componente principal e é uma tecnologia de gerenciamento de recursos e agendamento de tarefas na estrutura de processamento distribuído do Hadoop.

Neste artigo, discutiremos a instalação e configuração do Hadoop 2.7.4 em um cluster de nó único e testaremos a configuração executando o programa MapReduce chamado wordcount para contar o número de palavras no arquivo. Examinaremos mais alguns comandos importantes do Sistema de arquivos Hadoop.

Etapas para instalar o Hadoop

A seguir, é apresentado um resumo das tarefas envolvidas na configuração do Apache Hadoop.

Tarefa 1: A primeira tarefa na instalação do Hadoop incluiu a configuração de um modelo de máquina virtual que foi configurado com o Cent OS7. Pacotes como Java SDK 1.8 e Runtime Systems necessários para executar o Hadoop foram baixados e a variável de ambiente Java para Hadoop foi configurada editando bash_rc.

Tarefa 2: O pacote Hadoop Release 2.7.4 foi baixado do site apache e extraído na pasta opt. Que foi renomeado como Hadoop para facilitar o acesso.

Tarefa 3: Depois que os pacotes do Hadoop foram extraídos, a próxima etapa incluiu a configuração da variável de ambiente para o usuário do Hadoop e a configuração dos arquivos XML do nó do Hadoop. Nesta etapa, o NameNode foi configurado no core-site.xml e o DataNode foi configurado no hdfs-site.xml. O gerenciador de recursos e o nó foram configurados no yarn-site.xml.

Tarefa 4: O firewall foi desativado para iniciar o YARN e o DFS. O comando JPS foi usado para verificar se daemons relevantes estão sendo executados em segundo plano. O número da porta para acessar o Hadoop foi configurado para http: // localhost: 50070 /

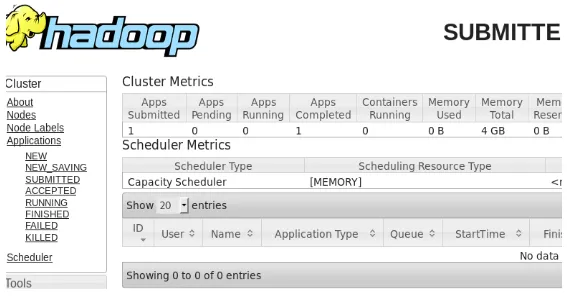

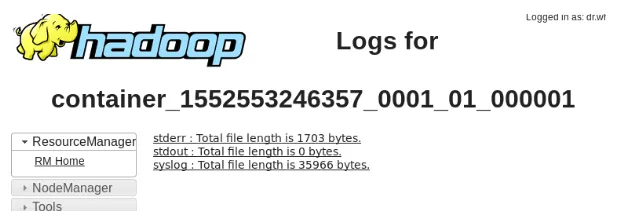

Tarefa 5: As próximas etapas foram usadas para verificar e testar o Hadoop. Para isso, criamos um arquivo de teste temporário no diretório de entrada do programa WordCount. O programa de redução de mapa Hadoop-MapReduce-examples2.7.4.jar foi usado para contar o número de palavras no arquivo. Os resultados foram avaliados no host local e os logs do aplicativo enviado foram analisados. Todos os aplicativos MapReduce enviados podem ser visualizados na interface online, o número da porta padrão sendo 8088.

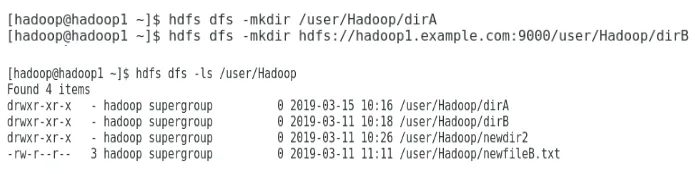

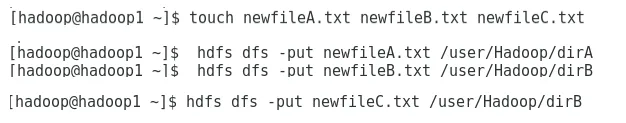

Tarefa 6: Na tarefa final, apresentaremos alguns comandos básicos do Hadoop File System e verificaremos seus usos. Veremos como um diretório pode ser criado dentro do sistema de arquivos Hadoop, para listar o conteúdo de um diretório, seu tamanho em bytes. Veremos ainda como excluir um diretório e arquivo específicos.

Resultados na instalação do Hadoop

A seguir, são mostrados os resultados de cada uma das tarefas acima:

Resultado da Tarefa 1

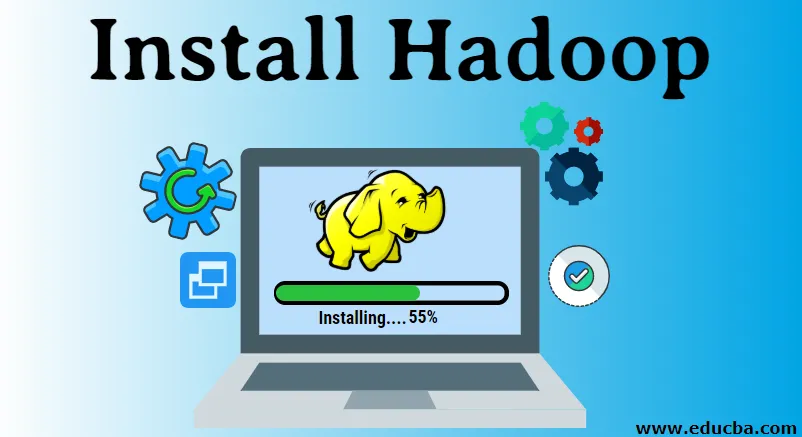

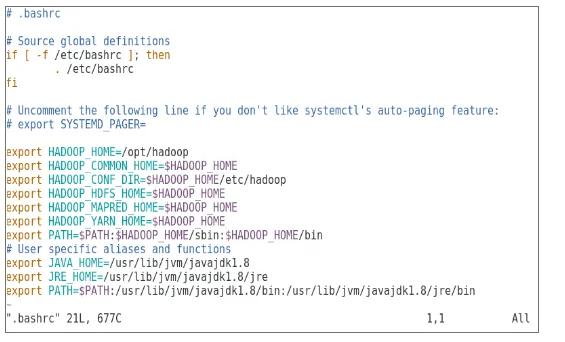

Uma nova máquina virtual com uma imagem cenOS7 foi configurada para executar o Apache Hadoop. A Figura 1 mostra como a imagem do CenOS 7 foi configurada na máquina virtual. A Figura 1.2 mostra a configuração da variável de ambiente JAVA em .bash_rc.

Figura 1: Configuração da máquina virtual

Figura 1.2: Configuração da variável de ambiente Java

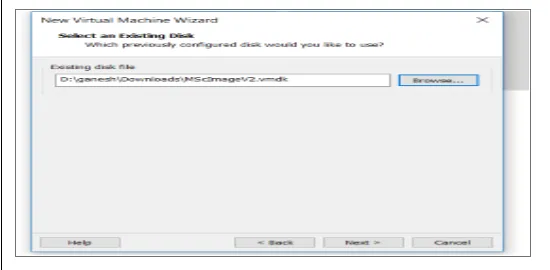

Resultado da Tarefa 2

A Figura 2 mostra a tarefa executada para extrair o pacote Hadoop 2.7.4 para a pasta opt.

Figura 2: Extração do pacote Hadoop 2.7.4

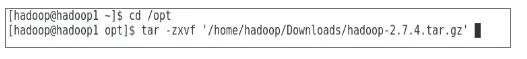

Resultado da Tarefa 3

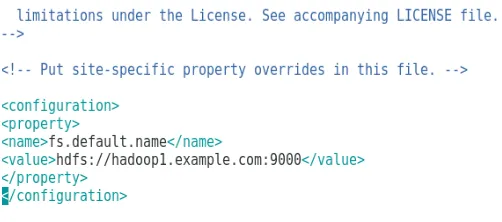

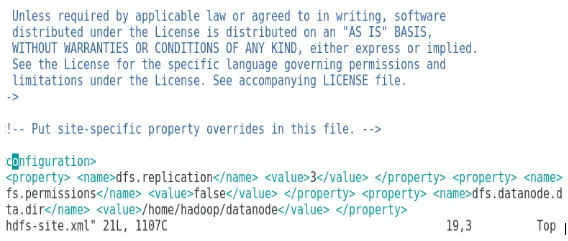

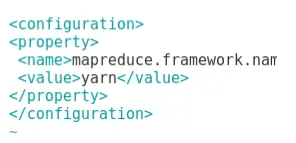

A Figura 3 mostra a configuração da variável de ambiente para o usuário do Hadoop. As Figuras 3.1 a 3.4 mostram a configuração dos arquivos XML necessários para a configuração do Hadoop.

Figura 3: Configurando a variável de ambiente para o usuário Hadoop

Figura 3.1: Configuração do core-site.xml

Figura 3.2: Configuração do hdfs-site.xml

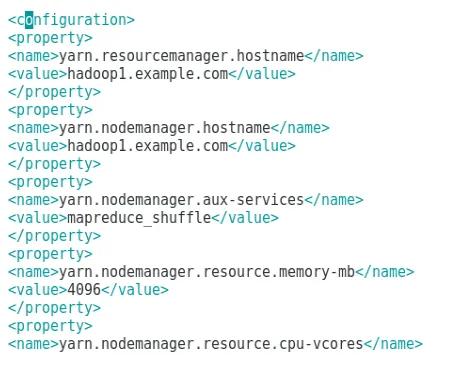

Figura 3.3: Configuração do arquivo mapred-site.xml

Figura 3.4: Configuração do arquivo yarn-site.xml

Resultado da Tarefa 4

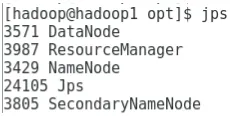

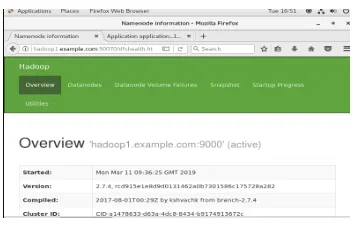

A Figura 4 mostra o uso do comando jps para verificar se os daemons relevantes estão em execução em segundo plano e a figura a seguir mostra a Interface do usuário on-line do Hadoop.

Figura 4: comando jps para verificar daemons em execução.

Figura 4.1: Acessando a interface online do Hadoop na porta http://hadoop1.example.com:50070/

Resultado da Tarefa 5

A Figura 5 mostra o resultado para o programa MapReduce chamado wordcount, que conta o número de palavras no arquivo. As próximas figuras exibem a interface do usuário on-line do gerenciador de recursos YARN para a tarefa enviada.

Figura 5: Resultados do programa MapReduce

Figura 5.1: Aplicativo enviado para redução de mapa.

Figura 5.2: Logs para o aplicativo MapReduce enviado.

Resultado da Tarefa 6

A Figura 6 mostra como criar um diretório no sistema de arquivos Hadoop e executar uma listagem do diretório hdfs.

Figura 6: Criando um diretório no sistema de arquivos Hadoop

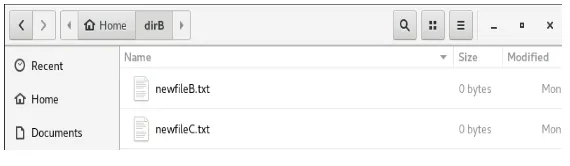

A Figura 6.1 mostra como colocar um arquivo no sistema de arquivos distribuídos Hadoop e a figura 6.2 mostra o arquivo criado no diretório dirB.

Figura 6.1: Criando um arquivo no HDFS.

Figura 6.2: Novo arquivo criado.

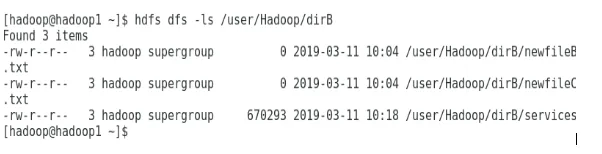

As próximas figuras mostram como listar o conteúdo de diretórios específicos:

Figura 6.3: Conteúdo do dirA

Figura 6.4: Conteúdo do dirB

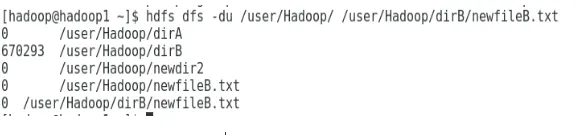

A próxima figura mostra como o tamanho do arquivo e do diretório pode ser exibido:

Figura 6.5: Exibir um tamanho de arquivo e diretório.

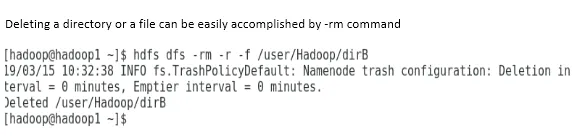

A exclusão de um diretório ou arquivo pode ser facilmente realizada pelo comando -rm.

Figura 6.6: Para excluir um arquivo.

Conclusão

O Big Data desempenhou um papel muito importante na formação do mercado mundial de hoje. A estrutura do Hadoop facilita a vida do analista de dados enquanto trabalha em grandes conjuntos de dados. A configuração do Apache Hadoop era bastante simples e a interface do usuário on-line fornecia ao usuário várias opções para ajustar e gerenciar o aplicativo. O Hadoop tem sido usado massivamente em organizações para armazenamento de dados, análise de aprendizado de máquina e backup de dados. O gerenciamento de uma grande quantidade de dados tem sido bastante útil devido ao ambiente distribuído do Hadoop e ao MapReduce. O desenvolvimento do Hadoop foi incrível quando comparado aos bancos de dados relacionais, pois eles não têm opções de ajuste e desempenho. O Apache Hadoop é uma solução amigável e de baixo custo para gerenciar e armazenar big data com eficiência. O HDFS também ajuda bastante no armazenamento de dados.

Artigos recomendados

Este é um guia para instalar o Hadoop. Aqui discutimos a introdução ao Instal Hadoop, instalação passo a passo do Hadoop, juntamente com os resultados da instalação do Hadoop. Você também pode consultar nossos outros artigos sugeridos para saber mais -

- Introdução ao Hadoop Streaming

- O que é o Hadoop Cluster e como funciona?

- Ecossistema Apache Hadoop e seus componentes

- Quais são as alternativas do Hadoop?