Diferença entre o Apache Storm e o Apache Spark

O Apache Storm é um sistema de computação em tempo real de código aberto, escalável, tolerante a falhas e distribuído. O Apache Storm está focado no processamento de fluxo ou processamento de eventos. O Apache Storm implementa um método tolerante a falhas para executar uma computação ou canalizar várias computações em um evento conforme ele flui para um sistema. O Apache Spark é uma estrutura de tecnologia de computação extremamente rápida e de cluster, projetada para computação rápida em processamento de dados em larga escala. O Apache Spark é um mecanismo de processamento distribuído, mas não vem com o gerenciador de recursos de cluster embutido e o sistema de armazenamento distribuído. Você precisa conectar um gerenciador de cluster e um sistema de armazenamento de sua escolha.

Apresentando mais sobre o Apache Storm vs Apache Spark:

- O Apache Storm é um mecanismo computacional contínuo paralelo a tarefas. Ele define seus fluxos de trabalho em gráficos acíclicos direcionados (DAGs) chamados topologias. Essas topologias são executadas até serem desligadas pelo usuário ou encontrar uma falha irrecuperável. O Apache Storm não é executado nos clusters do Hadoop, mas usa o Zookeeper e seu próprio minion worker para gerenciar seus processos. O Apache Storm pode ler e gravar arquivos no HDFS.

- O Apache Storm se integra às tecnologias de enfileiramento e banco de dados que você já usa. Uma topologia Storm consome fluxos de dados e processa esses fluxos de maneira arbitrariamente complexa, reparticionando os fluxos entre cada estágio da computação, conforme necessário. O Apache Storm é baseado em tuplas e fluxos. Uma tupla é basicamente o que são seus dados e como eles são estruturados.

- A estrutura do Apache Spark consiste no Spark Core e no conjunto de bibliotecas. O Spark Core executa e gerencia nosso trabalho, fornecendo uma experiência perfeita para o usuário final. Um usuário precisa enviar uma tarefa ao núcleo do Spark e o núcleo do Spark cuida de processamento, execução e resposta adicionais ao usuário. Temos a API do Spark Core em diferentes linguagens de script, como Scala, Python, Java e R.

- No Apache Spark, o usuário pode usar o Apache Storm para transformar dados não estruturados à medida que fluem para o formato desejado. Você precisa conectar um gerenciador de cluster e um sistema de armazenamento de sua escolha.

- Você pode escolher o Apache YARN ou o Mesos para o gerenciador de cluster do Apache Spark.

- Você pode escolher o Hadoop Distributed File System (HDFS), armazenamento em nuvem do Google, Amazon S3, Microsoft Azure para gerenciador de recursos do Apache Spark.

- O Apache Spark é um mecanismo de processamento de dados para modos de lote e streaming, com consultas SQL, processamento de gráficos e aprendizado de máquina.

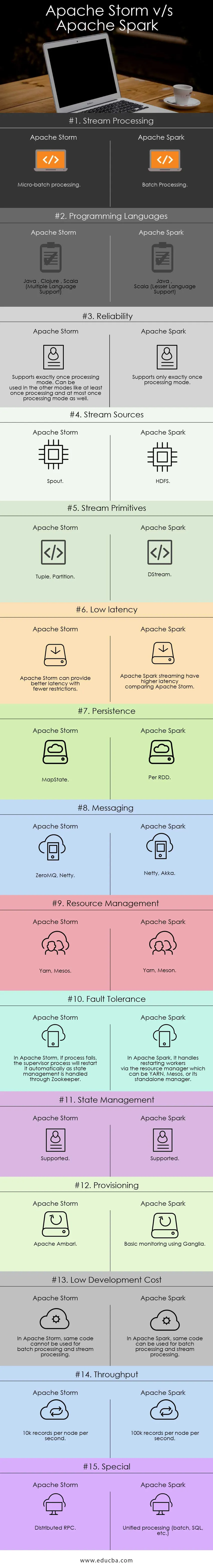

Comparação cara a cara entre Apache Storm x Apache Spark (Infográficos):

Principais diferenças entre o Apache Storm e o Apache Spark:

Abaixo estão as listas de pontos, descrevem as principais diferenças entre o Apache Storm e o Apache Spark:

- O Apache Storm executa cálculos paralelos a tarefas, enquanto o Apache Spark executa cálculos paralelos a dados.

- Se o nó do trabalhador falhar no Apache Storm, o Nimbus atribui a tarefa do trabalhador ao outro nó e todas as tuplas enviadas ao nó com falha serão atingidas pelo tempo limite e, portanto, reproduzidas automaticamente enquanto no Apache Spark, se o nó do trabalhador falhar, o sistema poderá recalcular a partir de a cópia restante dos dados e dados de entrada pode se perder se os dados não forem replicados.

- A garantia de entrega do Apache Strom depende de uma fonte de dados segura, enquanto a fonte de dados suportada pelo Apache Spark HDFS é segura.

- O Apache Storm é um mecanismo de processamento de fluxo para processar dados de fluxo em tempo real, enquanto o Apache Spark é um mecanismo de computação de uso geral.

Recursos do Apache Storm:

- Tolerância a falhas - onde, se os encadeamentos do trabalhador morrem ou um nó fica inoperante, os trabalhadores são reiniciados automaticamente

- Escalabilidade - Altamente escalável, o Storm pode manter o desempenho, mesmo sob carga crescente, adicionando recursos linearmente onde taxas de taxa de transferência de até um milhão de mensagens de 100 bytes por segundo por nó podem ser alcançadas

- Latência - o Storm executa a atualização de dados e a resposta de entrega de ponta a ponta em segundos ou minutos depende do problema. Tem latência muito baixa.

- Facilidade de uso na implantação e operação do sistema.

- Integrado ao Hadoop para aproveitar maiores taxas de transferência

- Fácil de implementar e pode ser integrado a qualquer linguagem de programação

- O Apache Storm é de código aberto, robusto e fácil de usar. Pode ser utilizado em pequenas empresas e grandes corporações

- Permite o processamento de fluxo em tempo real incrivelmente rápido, porque tem um enorme poder de processar os dados.

- O Apache Storm possui inteligência operacional.

- O Apache Storm fornece processamento de dados garantido, mesmo se algum dos nós conectados no cluster morrer ou as mensagens forem perdidas

Recursos do Apache Spark:

- Velocidade: O Apache Spark ajuda a executar um aplicativo no cluster Hadoop, até 100 vezes mais rápido na memória e 10 vezes mais rápido ao executar no disco.

- Processamento em tempo real: o Apache spark pode manipular dados de streaming em tempo real.

- Usabilidade : O Apache Spark tem capacidade para suportar várias linguagens como Java, Scala, Python e R

- Avaliação Preguiçosa: No Apache Spark, as transformações são de natureza preguiçosa. Dará resultado após a formação de um novo RDD a partir do existente.

- Integração com o Hadoop: O Apache Spark pode executar de forma independente e também no Hadoop YARN Cluster Manager e, portanto, pode ler os dados existentes do Hadoop.

- Tolerância a falhas: O Apache Spark fornece tolerância a falhas usando o conceito RDD. Os RDDs do Spark foram projetados para lidar com a falha de qualquer nó do trabalhador no cluster.

Tabela de comparação Apache Storm vs Apache Spark

Estou discutindo os principais artefatos e distinguindo entre o Apache Storm e o Apache Spark.

| Apache Storm | Apache Spark | |

| Processamento de Stream | Processamento de micro-lote | Processamento em lote |

| Linguagens de programação | Java, Clojure, Scala (suporte a vários idiomas) | Java, Scala (suporte a idiomas menores) |

| Confiabilidade | Suporta exatamente uma vez o modo de processamento. Pode ser usado em outros modos, como pelo menos uma vez o processamento e, no máximo, o modo de processamento também | Suporta apenas exatamente uma vez o modo de processamento |

| Fontes de fluxo | Bico; esquichar | HDFS |

| Primitivas de fluxo | Tupla, Partição | DStream |

| Baixa latência | O Apache Storm pode fornecer uma melhor latência com menos restrições | O streaming do Apache Spark tem maior latência comparando o Apache Storm |

| Persistência | MapState | Por RDD |

| Mensagens | ZeroMQ, Netty | Netty, Akka |

| Gestão de recursos | Mesos Yarn | Meson Yarn |

| Tolerância ao erro | No Apache Storm, se o processo falhar, o processo do supervisor o reiniciará automaticamente à medida que o gerenciamento de estado for tratado pelo Zookeeper | No Apache Spark, ele lida com a reinicialização de trabalhadores por meio do gerenciador de recursos, que pode ser YARN, Mesos ou seu gerente independente |

| Gerenciamento de Estado | Suportado | Suportado |

| Provisioning | Apache Ambari | Monitoramento básico usando Ganglia |

| Baixo custo de desenvolvimento | No Apache Storm, o mesmo código não pode ser usado para processamento em lote e processamento em fluxo | No Apache Spark, o mesmo código pode ser usado para processamento em lote e processamento em fluxo |

| Taxa de transferência | 10k registros por nó por segundo | 100k registros por nó por segundo |

| Especial | RPC distribuído | Processamento unificado (lote, SQL, etc.) |

Conclusão - Apache Storm vs Apache Spark:

O Apache Storm e o Apache Spark são ótimas soluções que resolvem o problema de ingestão e transformação de streaming. O Apache Storm e o Apache Spark podem fazer parte do cluster Hadoop para processamento de dados. O Apache Storm é uma solução para processamento de fluxo em tempo real. Mas o Storm é muito complexo para os desenvolvedores desenvolverem aplicativos por causa de recursos limitados.

O Apache Storm pode ser usado principalmente para processamento de Stream. Mas a indústria precisa de uma solução generalizada que possa resolver todos os tipos de problemas. Por exemplo, processamento em lote, processamento interativo de processamento de fluxo e processamento iterativo. Portanto, o Apache Spark entra em evidência, que é um mecanismo de computação de uso geral. Esse é o motivo pelo qual a demanda do Apache Spark está mais comparando outras ferramentas dos profissionais de TI. O Apache Spark pode lidar com diferentes tipos de problemas. Além disso, o Apache Spark é muito fácil para os desenvolvedores e pode se integrar muito bem ao Hadoop. O Apache Spark oferece a flexibilidade de trabalhar em diferentes idiomas e ambientes.

Artigo recomendado

Este foi um guia do Apache Storm vs Apache Spark, seu significado, comparação cara a cara, diferenças principais, tabela de comparação e conclusão. Você também pode consultar os seguintes artigos para saber mais -

- Iaas vs Azure Pass - diferenças que você deve saber

- Apache Hadoop vs Apache Spark | As 10 melhores comparações que você deve saber!

- 7 Guia incrível sobre o Apache Spark (Guia)

- As 15 melhores coisas que você precisa saber sobre o MapReduce vs Spark

- Hadoop vs Apache Spark - coisas interessantes que você precisa saber