Diferença entre Dados pequenos e dados grandes

Dados pequenos, nada mais são do que dados suficientemente pequenos para humanos em um volume e também para formatação, que os tornam acessíveis, informativos e acionáveis. O processamento de dados tradicional não pode lidar com dados grandes ou complexos, esses dados são denominados Big Data. Quando o volume de dados cresce além de um certo limite, os sistemas e metodologias tradicionais não são suficientes para processar ou transformar dados em um formato útil. É por isso que os dados geralmente são classificados em dois - dados pequenos versus dados grandes

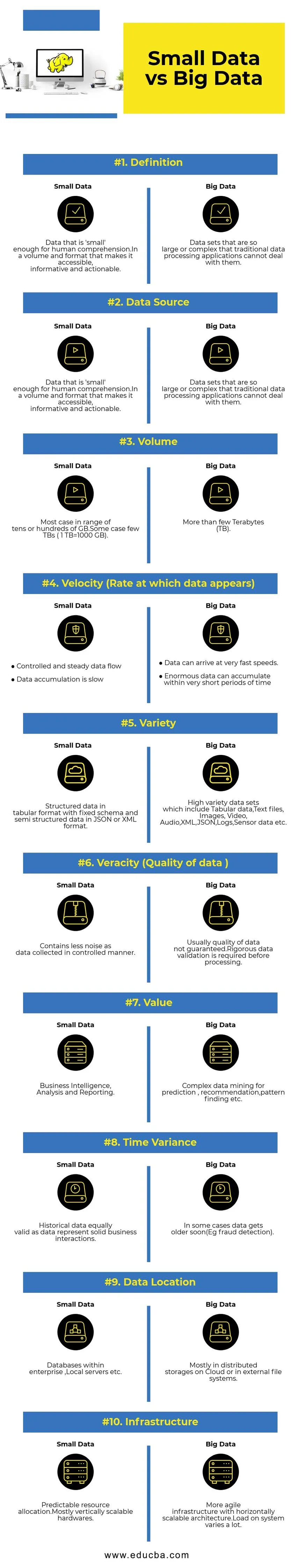

Comparação cara a cara entre dados pequenos e dados grandes (Infográficos)

Abaixo está a diferença top 10 entre dados pequenos e dados grandes

Principais diferenças entre dados pequenos e dados grandes

- Coleta de dados - Normalmente, os dados pequenos fazem parte dos sistemas OLTP e são coletados de uma maneira mais controlada e inseridos na camada de cache ou no banco de dados. Os bancos de dados terão réplicas de leitura para oferecer suporte a consultas analíticas imediatas, se necessário. O pipeline de coleta de Big Data terá filas como AWS Kinesis ou Google Pub / Sub para equilibrar dados de alta velocidade. A jusante terá pipelines de streaming para análises em tempo real e trabalhos em lote para processamento de dados a frio.

- Processamento de dados - Como a maioria dos dados pequenos gerados por meio do sistema de transações, as análises sobre ele serão orientadas em lote na maioria das vezes. Em alguns casos raros, as consultas de análise são executadas diretamente sobre os sistemas de transações. Os ambientes de Big Data terão pipelines de processamento em lote e fluxo. Um fluxo é usado para análises em tempo real, como detecção de fraude no cartão de crédito ou previsão de preço das ações. Processamento em lote usado para implementar lógica de negócios complexa com dados e algoritmos avançados.

- Escalabilidade - Os sistemas de dados pequenos geralmente escalam verticalmente. A escala vertical está aumentando a capacidade do sistema, adicionando mais recursos à mesma máquina. A escala vertical é cara, mas menos complexa de gerenciar. Os sistemas de Big Data dependem principalmente da arquitetura escalável horizontalmente, o que proporciona mais agilidade a um custo menor. As máquinas virtuais preventivas disponíveis na nuvem tornam os sistemas escaláveis horizontalmente ainda mais acessíveis.

- Modelagem de dados - dados pequenos gerados a partir de sistemas de transações estarão em formato normalizado. Os pipelines de dados ETL (Extract Transform Load) convertem-nos em esquema estrela ou floco de neve em um armazém de dados. Aqui, o esquema é sempre aplicado ao escrever dados, o que é relativamente fácil, pois os dados são mais estruturados. Como mencionado acima, os dados tabulares são apenas uma fração do Big Data. Aqui, os dados são replicados muito mais por vários motivos, como transferência de falhas ou devido a alguma limitação do mecanismo de banco de dados subjacente (por exemplo, alguns bancos de dados suportam apenas um índice secundário por conjunto de dados). Um esquema não é imposto ao escrever. Em vez disso, um esquema é validado ao ler dados.

- Acoplamento de armazenamento e computação - Nos bancos de dados tradicionais que lidam principalmente com dados pequenos, o armazenamento e a computação são fortemente acoplados. A inserção e a recuperação de dados de e para o banco de dados só são possíveis através da interface fornecida. Os dados não podem ser colocados diretamente no sistema de arquivos do banco de dados ou os dados existentes não podem ser consultados usando outros mecanismos de banco de dados. Na verdade, essa arquitetura ajuda muito a garantir a integridade dos dados. Os sistemas de Big Data têm um acoplamento muito frouxo entre armazenamento e computação. Normalmente, os dados são armazenados em um sistema de armazenamento de dados distribuído, como HDFS, AWS S3 ou Google GCS, e o mecanismo de cálculo para consultar dados ou fazer ETL selecionado posteriormente. Por exemplo, consultas interativas podem ser executadas usando Presto (Link) e ETL usando Apache Hive nos mesmos dados.

- Ciência de dados - Os algoritmos de aprendizado de máquina exigem dados de entrada em um formato bem estruturado e codificado corretamente, e na maioria das vezes os dados de entrada serão de sistemas transacionais como um armazém de dados e armazenamento de Big Data como um lago de dados. Os algoritmos de aprendizado de máquina executados exclusivamente em dados pequenos serão fáceis, pois o estágio de preparação de dados é restrito. Preparar e enriquecer dados no ambiente de Big Data leva muito mais tempo. O Big Data oferece muitas opções para experimentação de ciência de dados devido ao alto volume e variedade de dados.

- Segurança de dados - As práticas de segurança para dados pequenos que residem no armazém de dados corporativos ou nos sistemas de transações fornecidos pelos provedores de banco de dados correspondentes, que podem incluir privilégios de usuário, criptografia de dados, hash etc. A proteção de sistemas de Big Data é muito mais complicada e desafiadora. As práticas recomendadas de segurança incluem criptografar dados em repouso e em trânsito, isolar a rede de clusters, regras fortes de controle de acesso, etc.

Tabela de comparação de dados pequenos e big data

| Base de comparação | Dados pequenos | Big Data |

| Definição | Dados que são 'pequenos' o suficiente para a compreensão humana. Em um volume e formato que os torna acessíveis, informativos e acionáveis | Conjuntos de dados que são tão grandes ou complexos que os aplicativos tradicionais de processamento de dados não conseguem lidar com eles |

| Fonte de dados | ● Dados de sistemas corporativos tradicionais, como ○ Planejamento de recursos empresariais ○ Gerenciamento de relacionamento com cliente (CRM) ● Dados financeiros, como dados do razão geral ● Dados da transação de pagamento do site | ● Adquirir dados do ponto de venda ● Dados de fluxo de cliques de sites ● Dados de fluxo GPS - dados de mobilidade enviados para um servidor ● Mídias sociais - facebook, twitter |

| Volume | A maioria dos casos em um intervalo de dezenas ou centenas de GB. Alguns casos, alguns TBs (1 TB = 1000 GB) | Mais do que alguns Terabytes (TB) |

| Velocidade (taxa na qual os dados são exibidos) | ● Fluxo de dados controlado e constante ● A acumulação de dados é lenta | ● Os dados podem chegar a velocidades muito rápidas. ● Dados enormes podem se acumular em períodos muito curtos |

| Variedade | Dados estruturados em formato de tabela com esquema fixo e dados semiestruturados no formato JSON ou XML | Conjuntos de dados de alta variedade, que incluem dados tabulares, arquivos de texto, imagens, vídeo, áudio, XML, JSON, logs, dados do sensor etc. |

| Veracidade (qualidade dos dados) | Contém menos ruído conforme os dados coletados de maneira controlada. | Normalmente, a qualidade dos dados não é garantida. É necessária uma validação rigorosa dos dados antes do processamento. |

| Valor | Inteligência de negócios, análise e relatórios | Mineração de dados complexa para previsão, recomendação, localização de padrões etc. |

| Variação de tempo | Dados históricos igualmente válidos, pois representam interações comerciais sólidas | Em alguns casos, os dados envelhecem em breve (por exemplo, detecção de fraude). |

| Localização dos dados | Bancos de dados dentro de uma empresa, servidores locais etc. | Principalmente em armazenamentos distribuídos na nuvem ou em sistemas de arquivos externos. |

| A infraestrutura | Alocação previsível de recursos. Hardware quase verticalmente escalável | Infra-estrutura mais ágil com uma arquitetura horizontalmente escalável. A carga no sistema varia muito. |

Conclusão - Small Data vs Big Data

O objetivo final da análise de dados para obter informações oportunas para apoiar a tomada de decisão. A categorização de dados em Small e Big ajuda a enfrentar desafios na análise de dados de cada mundo separadamente, com as ferramentas adequadas. A linha entre duas categorias varia com os sistemas avançados de processamento de dados emergentes, o que torna a consulta de big data muito mais rápida e menos complexa.

Artigos recomendados:

Este foi um guia para dados pequenos versus dados grandes, seu significado, comparação cara a cara, diferenças principais, tabela de comparação e conclusão. este artigo inclui todas as diferenças importantes entre dados pequenos e dados grandes. Você também pode consultar os seguintes artigos para saber mais -

- Big Data vs Data Science - Como são diferentes?

- Big Data: Importante da Confluência de Tecnologia e Análise de Negócios

- As 5 principais tendências de big data que as empresas terão que dominar

- 16 dicas interessantes para transformar Big Data em grande sucesso