Introdução aos comandos do Hadoop fs

Neste artigo, examinaremos os comandos de manipulação de arquivos do HADOOP, que são usados para gerenciar os arquivos pelo console.

Você precisará de um sistema Linux e da versão mais recente do Hadoop. Para imprimir a versão do Hadoop, para saber por quem a liberação foi criada, o valor da soma de verificação, basta executar o comando abaixo após o login na plataforma Hadoop.

Comando: versão do Hadoop

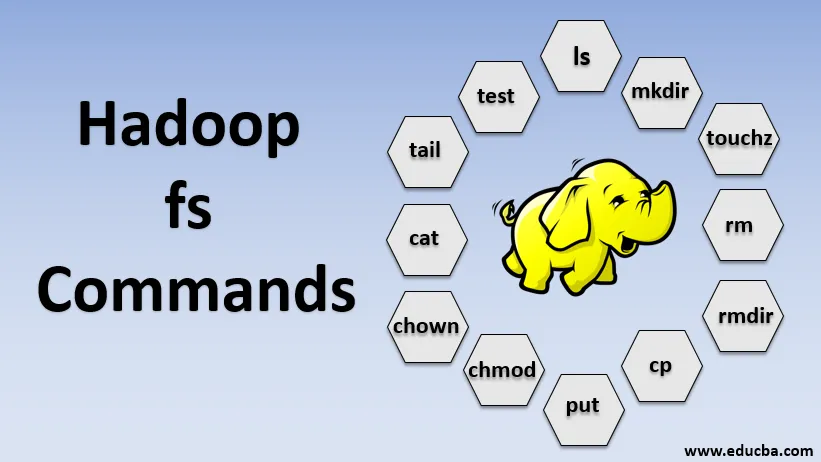

Comandos do Hadoop fs

Agora, vamos aprender como usar os comandos HADOOP fs.

Vamos começar com o básico. Basta digitar esses comandos no PUTTY ou em qualquer console com o qual você se sinta confortável.

1. hadoop fs -ls

Para um diretório, ele retorna a lista de arquivos e diretórios, enquanto que, para um arquivo, retorna as estatísticas no arquivo.

hadoop fs -lsr: serve para listar recursivamente os diretórios e arquivos em pastas específicas.

- Exemplo : hadoop fs -ls / ou hadoop fs -lsr

- -d: É usado para listar os diretórios como arquivos simples.

- -h: É usado para formatar o tamanho dos arquivos de maneira legível por humanos, além do número de bytes.

- -R: É usado para listar recursivamente o conteúdo dos diretórios.

2. hadoop fs -mkdir

Este comando segue o caminho como argumento e cria diretórios em hdfs.

- Exemplo : hadoop fs -mkdir / user / datahub1 / data

3. hadoop fs -touchz

Ele cria um arquivo vazio e não utiliza espaço

- Exemplo: URI do hadoop fs -touchz

4. hadoop fs -rm

Exclua os arquivos especificados como argumento. Nós devemos especificar a opção -r para excluir o diretório inteiro. E se a opção -skipTrash for especificada, ela ignorará a lixeira e o arquivo será excluído imediatamente.

- Exemplo : hadoop fs -rm -r /user/test1/abc.text

5. hadoopfs -rmdir

Remove arquivos e permissões de diretórios e subdiretórios. Basicamente, é a versão expandida do Hadoop fs -rm.

6. hadoop fs -cp

Ele copia o arquivo de um local para outro

- Exemplo : hadoop fs -cp /user/data/abc.csv / user / datahub

7. hadoop fs -copyFromLocal

Ele copia o arquivo do edgenode para o HDFS.

8. hadoop fs -put

Ele copia o arquivo do edgenode para o HDFS, é semelhante ao comando anterior, mas também lê as entradas da entrada padrão stdin e grava no HDFS

- Exemplo : hadoop fs -put abc.csv / user / data

hadoop fs -put -p: O sinalizador preserva o acesso, a hora da modificação, a propriedade e o modo.

hadoop fs -put -f: Este comando substitui o destino se o arquivo já existir antes da cópia.

9. hadoop fs -moveFromLocal

É semelhante a copiar do local, exceto que o arquivo de origem é excluído do edgenode local após ser copiado para o HDFS

- Exemplo : fs -moveFromLocal abc.text / user / data / acb.

10. hadoop fs -copyToLocal

Ele copia o arquivo do HDFS para o edgenode.

- Exemplo : fs -copyToLocal abc.text / localpath

11. hadoop fs -chmod

Este comando nos ajuda a alterar o acesso de um arquivo ou diretório

- Exemplo : hadoop fs -chmod (-R) (caminho)

12. hadoop fs -chown

Este comando nos ajuda a alterar a propriedade de um arquivo ou diretório

- Exemplo : hadoop fs -chown (-R) (OWNER) (:( GROUP)) PATH

13. hadoop fs -cat

Imprime o conteúdo de um arquivo HDFS no terminal

- Exemplo : hadoop fs -cat /user/data/abc.csv

14. hadoop fs -tail

Ele exibe o último KB do arquivo HDFS no stdout

- Exemplo : hadoop fs -tail / in / xyzfile

15. teste hadoop fs

Este comando é usado para operações de teste de arquivo HDFS, retorna 0 se verdadeiro.

- - e: verifica se o arquivo existe.

- -z: verifica se o arquivo tem comprimento zero

- -d / -f: verifica se o caminho é diretório / arquivo, respectivamente

Aqui, discutimos um exemplo em detalhes

- Exemplo : hadoop fs -test - (defz) /user/test/test1.text

16. hadoop fs -du

Exibe tamanhos de arquivos e diretórios contidos no diretório especificado ou o tamanho de um arquivo, caso seja um arquivo

17. hadoop fs -df

Exibe espaço livre

18. hadoop fs -checksum

Retorna as informações da soma de verificação de um arquivo

19. hadoop fs -getfacl

Ele exibe a lista de controle de acesso (ACLs) do arquivo ou diretório específico

20. hadoop fs -count

Conta o número de diretórios, arquivos e bytes no caminho que corresponde ao padrão de arquivo especificado.

21. hadoop fs -setrep

Altera o fator de replicação de um arquivo. E se o caminho for um diretório, o comando altera o fator de replicação de todos os arquivos no diretório.

- Exemplo : hadoop fs -setrep -R / user / datahub: é usado para aceitar o recurso de retorno e não tem efeito.

hadoop fs - setrep -w / user / datahub : aguarda a conclusão da replicação

22. hadoop fs -getmerge

Concatena arquivos HDFS na origem no arquivo local de destino

- Exemplo : hadoop fs -getmerge / user / datahub

23. hadoop fs -appendToFile

Anexa uma única fonte ou várias fontes do sistema de arquivos local ao destino.

- Exemplo : hadoop fs -appendToFile xyz.log data.csv / in / appendfile

24. hadoop fs -stat

Ele imprime as estatísticas sobre o arquivo ou diretório.

- Exemplo : hadoop fs -stat (formato)

Conclusão - Comandos do Hadoop fs

Portanto, passamos por quase todos os comandos necessários para o manuseio de arquivos e visualizamos os dados dentro dos arquivos. Você pode modificar seus arquivos e inserir dados na plataforma Hadoop agora.

Artigos recomendados

Este é um guia para os comandos do Hadoop fs. Aqui discutimos a introdução aos comandos Hadoop fs, juntamente com seu exemplo em detalhes. Você também pode consultar os seguintes artigos para saber mais:

- Instale o Hadoop

- Ferramentas Hadoop

- Arquitetura Hadoop

- Componentes do Hadoop

- Comandos do Hadoop fs