Introdução do Processo ETL

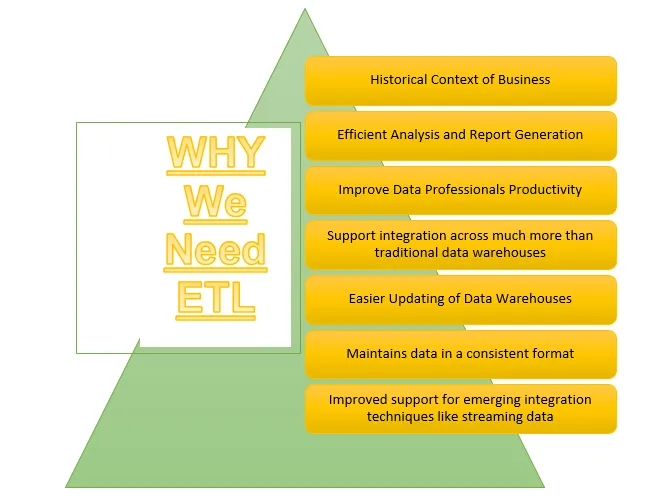

ETL é um dos processos importantes exigidos pelo Business Intelligence. O Business Intelligence conta com os dados armazenados nos data warehouses, a partir dos quais muitas análises e relatórios são gerados, o que ajuda na construção de estratégias mais eficazes e leva a insights táticos e operacionais e à tomada de decisões.

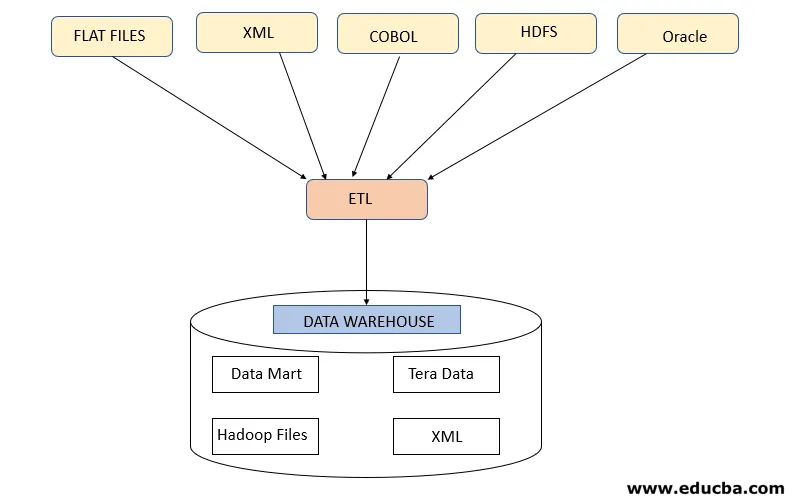

ETL refere-se ao processo Extrair, Transformar e Carregar. É um tipo de etapa de integração de dados em que os dados provenientes de diferentes fontes são extraídos e enviados para os data warehouses. Os dados são extraídos de vários recursos, primeiro são transformados para convertê-los em um formato específico, de acordo com os requisitos de negócios. Várias ferramentas que ajudam a executar essas tarefas são:

- IBM DataStage

- Abinitio

- informática

- Quadro

- Talend

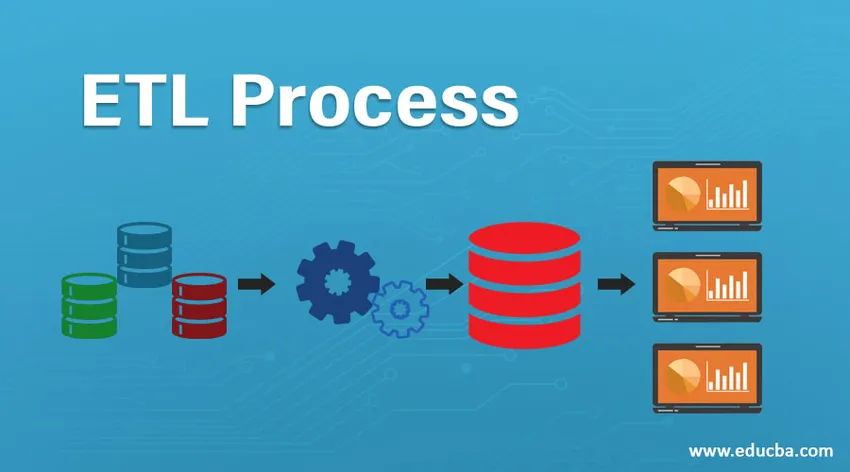

Processo ETL

Como funciona?

O processo ETL é um processo de três etapas que começa com a extração dos dados de várias fontes de dados e, em seguida, os dados brutos passam por várias transformações para torná-lo adequado para armazenar no armazém de dados e carregá-lo em data warehouses no formato necessário e prepará-lo para análise.

Etapa 1: Extrair

Esta etapa refere-se à busca dos dados necessários de várias fontes que estão presentes em diferentes formatos, como XML, arquivos Hadoop, arquivos simples, JSON etc. Os dados extraídos são armazenados na área de preparação onde outras transformações estão sendo executadas. Portanto, os dados são verificados minuciosamente antes de movê-los para data warehouses, caso contrário, será um desafio reverter as alterações nos data warehouses.

É necessário um mapa de dados adequado entre a origem e o destino antes que a extração de dados ocorra, pois o processo ETL precisa interagir com vários sistemas, como Oracle, Hardware, Mainframe, sistemas em tempo real, como ATM, Hadoop, etc., enquanto obtém dados desses sistemas .

Nota - Mas deve-se cuidar para que esses sistemas não sejam afetados durante a extração.

Estratégias de extração de dados

- Extração completa: isso é seguido quando dados inteiros de fontes são carregados nos data warehouses que mostram que o data warehouse está sendo preenchido pela primeira vez ou que nenhuma estratégia foi feita para a extração de dados.

- Extração parcial (com notificação de atualização): Essa estratégia também é conhecida como delta, onde apenas os dados que estão sendo alterados são extraídos e atualizam os data warehouses

- Extração parcial (sem notificação de atualização): essa estratégia se refere à extração de dados específicos requeridos de fontes de acordo com a carga nos data warehouses, em vez de extrair dados inteiros.

Etapa 2: transformar

Este passo é o passo mais importante do ETL. Nesta etapa, muitas transformações são executadas para preparar os dados para carregamento nos data warehouses, aplicando as transformações abaixo:

A. Transformações básicas: essas transformações são aplicadas em todos os cenários, pois são necessárias ao carregar os dados que foram extraídos de várias fontes, nos data warehouses

- Limpeza ou aprimoramento de dados: refere-se à limpeza dos dados indesejados da área de preparação, para que dados incorretos não sejam carregados dos data warehouses.

- Filtragem: aqui filtramos os dados necessários de uma grande quantidade de dados presentes de acordo com os requisitos comerciais. Por exemplo, para gerar relatórios de vendas, é necessário apenas registros de vendas para esse ano específico.

- Consolidação: os dados extraídos são consolidados no formato necessário antes de carregá-los nos data warehouses.4.

- Padronizações: os campos de dados são transformados para trazê-los para o mesmo formato necessário, por exemplo, o campo de dados deve ser especificado como MM / DD / AAAA.

B. Transformações avançadas: esses tipos de transformações são específicos aos requisitos de negócios.

- União: Nesta operação, os dados de 2 ou mais fontes são combinados para gerar dados apenas com as colunas desejadas, com linhas relacionadas entre si

- Verificação de validação de limite de dados: os valores presentes em vários campos são verificados se estiverem corretos ou não, como número de conta bancária nulo, no caso de dados bancários.

- Use pesquisas para mesclar dados: vários arquivos simples ou outros arquivos são usados para extrair as informações específicas, executando a operação de pesquisa nelas.

- Usando qualquer validação de dados complexos: Muitas validações complexas são aplicadas para extrair dados válidos apenas dos sistemas de origem.

- Valores calculados e derivados: vários cálculos são aplicados para transformar os dados em algumas informações necessárias

- Duplicação: os dados duplicados provenientes dos sistemas de origem são analisados e removidos antes de carregá-los nos data warehouses.

- Reestruturação de chaves: No caso de capturar dados que mudam lentamente, várias chaves substitutas precisam ser geradas para estruturar os dados no formato necessário.

Nota - O MPP-Massive Parallel Processing é usado algumas vezes para executar algumas operações básicas, como filtragem ou limpeza de dados na área de preparação, para processar uma grande quantidade de dados mais rapidamente.

Etapa 3: Carregar

Esta etapa refere-se ao carregamento dos dados transformados no armazém de dados, de onde eles podem ser usados para gerar muitas decisões analíticas, além de gerar relatórios.

1. Carga inicial: esse tipo de carga ocorre ao carregar dados nos data warehouses pela primeira vez.

2. Carga Incremental: Esse é o tipo de carga que é feita para atualizar o data warehouse periodicamente, com alterações ocorrendo nos dados do sistema de origem.

3. Atualização Completa: Este tipo de carregamento refere-se à situação em que os dados completos da tabela são excluídos e carregados com novos dados.

O data warehouse permite os recursos OLAP ou OLTP.

Desvantagens do processo ETL

- Aumentando dados - Há um limite de dados sendo extraídos de várias fontes pela ferramenta ETL e enviados aos data warehouses. Assim, com o aumento de dados, o trabalho com a ferramenta ETL e os data warehouses se torna complicado.

- Personalização - refere-se às soluções ou respostas rápidas e eficazes aos dados gerados pelos sistemas de origem. Mas o uso da ferramenta ETL aqui diminui o processo.

- Caro - Usar um data warehouse para armazenar uma quantidade crescente de dados gerados periodicamente é um alto custo que uma organização precisa pagar.

Conclusão - Processo ETL

A ferramenta ETL compreende processos de extração, transformação e carregamento, onde ajuda a gerar informações a partir dos dados coletados de vários sistemas de origem. Os dados do sistema de origem podem vir em qualquer formato e podem ser carregados em qualquer formato desejado nos data warehouses, portanto, a ferramenta ETL deve suportar conectividade com todos os tipos desses formatos.

Artigos recomendados

Este é um guia para um processo ETL. Aqui discutimos a introdução, Como isso funciona ?, Ferramentas ETL e suas desvantagens. Você também pode consultar nossos outros artigos sugeridos para saber mais:

- Ferramentas ETL da Informatica

- Ferramentas de teste ETL

- O que é ETL?

- O que é teste ETL?